추천 콘텐츠

무엇이 문제인가?

지금까지 딥페이크 기술의 특징과 딥페이크를 통한 폭력 및 창작의 사례를 살펴보았다. 폭력성과 창작성이라는 딥페이크의 두 얼굴을 통해 알 수 있었던 것은 딥페이크로 얼굴을 바꾸는 것이 인간 정체성 및 주체성과 관련해 새로운 문제를 야기하고 있다는 사실이다.

딥페이크는 영상 속 화자나 행위자가 지닌 고유의 정체성을 얼굴 바꿔치기라는 손쉬운 방식을 통해 전복한다. 이는 본래의 화자가 전달했던 신뢰와 정보의 진정성을 훼손하고, 수용자와 관계성을 지닌 인물이 영상 속 행위를 하는 듯한 느낌을 준다. 이는 독특한 정서적 효과로 이어진다. 어떤 경우든, 원본 영상의 화자와 조작된 영상에 활용된 얼굴 이미지 주인의 동의를 얻지 않고 딥페이크 영상이 제작되는 경우가 많기 때문에, 두 사람의 정체성 모두를 도용하는 문제가 발생한다. 딥페이크는 ‘드러난 얼굴’ 뿐 아니라 ‘감춰진 얼굴’의 정체성과 권리를 어떻게 보호할 것인가의 문제와 관련되는 셈이다. 딥페이크로 인한 정체성 도용의 문제를 쉽사리 해결할 수 없는 것은 이 때문이다.

한편, 최근 딥페이크가 고인이 된 영화배우를 재현하거나 버추얼 인플루언서 등을 제작하는 데 쓰이면서 기술의 긍정적 쓰임새에 대한 기대감 또한 커지는 중이다. 아직은 기술적 발전 정도나 비용 효율성 면에서 한계가 존재하지만, 딥페이크를 영화 제작이나 마케팅 등에 활용하려는 시도는 더욱 많아질 것이라 예상된다. 문제는 딥페이크를 통해 되살아나거나 새롭게 태어난 인물을 독립적이고 사회적인 주체로서 인정하고 수용할 수 있을 것인가 하는 지점이다. 고인이 된 영화배우를 딥페이크로 제작한 경우, 이 배우가 수행한 연기의 주인은 본래의 영화배우인가, 대역 배우인가, 아니면 딥페이크 제작자인가? 버추얼 인플루언서는 ‘영원히 22살’이라는 설정처럼 오랜 시간 동안, 다른 인플루언서들처럼 이용자들과 허물없이 소통할 수 있을까? 딥페이크가 창작의 도구로 자리 잡는 과정에서는 이 기술로 만들어진 얼굴이 비즈니스와 마케팅 수단을 넘어 창작의 주체이자 행위의 담보자로서 인정받을 수 있는지의 문제가 필연적으로 대두할 것이다. 창의성의 주체로서 인간의 고유성을 어떻게 해석하느냐의 문제와 더불어서 말이다.

무엇을 하고 있나?

이러한 문제들에 우리 사회는 어떻게 대응하고 있을까? 아직까지 학계와 산업 현장의 움직임은 딥페이크로 인한 정체성 도용과 허위정보 확산 등의 부작용에 대응하는 데 집중돼 있다. 딥페이크와 창작의 문제는 기술과 사례를 개발해야 하는 긍정적인 사안으로 인식되거나 생성 AI 를 둘러싼 예술적, 미학적 논의를 필요로 하는, 기술 전반에 대한 근본적이고 철학적인 의제로 여겨지기 때문일 것이다. 그렇다면 딥페이크로 인한 폭력의 문제에 대응하기 위해 어떤 해결책이 논의되고 있을까? 플랫폼 사업자와 같은 인터넷 서비스 산업의 노력과, 학계를 중심으로 개발되는 대응책을 기술적 차원, 법적·제도적 차원, 사회적 차원으로 살펴보려 한다.

사후적 대응에 멈출 수밖에 없는 플랫폼

딥페이크에 대한 산업적 대응이 필요하다는 논의는 2017년 12월, 인터넷 언론인 ‘마더보드 (Motherboard)’의 한 기사로 촉발됐다. 해당 기사는 레딧에 딥페이크로 인한 포르노 영상이 게시되고 있음을 문제 삼았다.[1] 레딧은 이듬해 2월 ‘r/deepfakes’와 같은 딥페이크 관련 커뮤니티인 서브레딧(subreddit을 폐쇄하는 것으로 논란에 대응했다. 포르노 배우의 얼굴이 여배우의 얼굴로 바꿔치기 된 영상처럼, 등장인물의 ‘명시적 동의(explicit consent)’ 없이 제작됐음이 명백한 포르노그래피의 제작과 유통을 막겠다는 방침의 일환이었다. 이어 ‘포르노허브(Pornhub)’와 ‘트위터(Twitter)’, ‘지피캣(Gfycat)’과 ‘디스코드 ’ 등의 플랫폼이 딥페이크 검색 관련 키워드를 금지하고, 플랫폼에 딥페이크 영상을 게재할 경우 별도의 고지 없이 이를 삭제하고 업로더의 활동을 금지하겠다는 방침을 밝혔다. ‘구글(Google)’도 ‘비자발적 합성 포르노 이미지(involuntary synthetic pornographic imagery)’와 관련된 검색 결과에 대해 차단을 요청할 수 있도록 정책을 업데이트했다.[2] 젤렌스키 대통령의 항복 영상이 공개되었을 때 ‘메타(Meta)’는 ‘오해의 소지가 있는 미디어 조작에 대한 자사 정책을 위반했다’는 이유로 영상을 신속히 검토해 삭제했고, 유튜브 또한 허위정보에 대한 자사 정책을 위반했다는 이유로 조작 영상을 삭제했다. 고인(故人)의 사진을 영상으로 복원하는 서비스를 제공하는 마이헤리티지는 자사 서비스가 살아있는 인물의 모습을 조작하는 용도로 악용될 것을 우려해 이용자들에게 살아 있는 사람의 사진을 올리지 말라고 경고하고, 아무나 사용할 수 있도록 서비스를 제공하지는 않을 것임을 밝힌 바 있다.

영상을 삭제하거나 금지한 플랫폼 사업자들의 대응은 나쁜 목적을 갖고 제작되지 않은 제작된 여타 딥페이크 영상들이 여전히 해당 플랫폼에서 배포, 유통될 수 있도록 한다는 점에서 이례적인 조치다. 한편으로는 그만큼 여러 플랫폼들이 딥페이크 기술의 잠재적 위험성과 악용 가능성을 깊이 우려하는 것으로 해석된다. 문제는 플랫폼의 대응이 대부분 딥페이크 관련 키워드를 금지하거나, 플랫폼 사업자가 수동으로 식별해 삭제하는 방식에 의존하고 있다는 점이다. 이러한 방법은 일면 효과적이지만 모든 악의적 콘텐츠를 처리할 수 없다는 점, 사용자가 악의적 영상을 발견하여 신고할 때쯤이면 이미 영상이 대량으로 유통되었을 가능성이 크다는 점에서 한계가 있다. 특히, 딥페이크 관련 자료나 영상을 업로드하고 유통하는 ‘모든’ 이용자들을 추적할 수 없다는 점에서 사후적인 대응이라는 한계가 대두한다. 영상 제작의 직접적 책임이 없는 플랫폼 사업자가 딥페이크가 야기하는 문제들에 적극적으로 대응한다는 점에서는 충분히 의미가 있지만, 기계가 스스로 딥페이크 영상을 만들어 내기 시작하는 상황에서 이용자의 신고에 의존하는 플랫폼의 대응은 한계를 가질 수밖에 없다. 실제로 다수의 딥페이크 커뮤니티가 레딧의 정책적 대응 이후에도 상당 기간 운영된 바 있다.

아울러 플랫폼의 대응은 사업자마다 기준이 상이하다. 같은 사업자도 시기나 대상 영상에 따라 정책이 달라질 수 있다는 점에서 딥페이크 관련 문제의 근본적인 해결책이 되기 어렵다. 미국의 낸시 펠로시(Nancy Pelosi) 하원의장이 술이나 약에 취한 것처럼 보이도록 조작된 동영상이 퍼졌을 때의 사례가 이를 보여 준다. 딥페이크가 활용된 것은 아니지만, 영상의 속도를 늦춰 악의적으로 메시지를 조작했던 이 영상에 대해 유튜브와 페이스북은 각기 다르게 대응했다. 유튜브는 미디어 관련 정책을 위반했다는 이유로 해당 영상을 삭제했지만, 페이스북은 ‘일부 허위정보(partly false)’라는 경고 문구만을 단 채 영상을 지우지 않았다. 영상이 조작됐다는 점은 인정되지만 ‘페이스북에 올린 정보가 사실이어야만 한다는 규정은 없다’는 점이 그 이유였다.

딥페이크 기술과 탐지 기술의 쫓고 쫓기는 게임

AI 기술을 통해 딥페이크 합성 여부를 탐지하려는 시도도 여러모로 이뤄지고 있다. 딥페이크 탐지 기술은 현재도 활발하게 연구되는 분야인 만큼, 앞으로 더욱 발전된 논리가 개발될 것으로 기대된다. 주요 탐지 기술의 기본 원리는, 적어도 현재까지는, 크게 세 가지로 구분할 수 있다.[3]

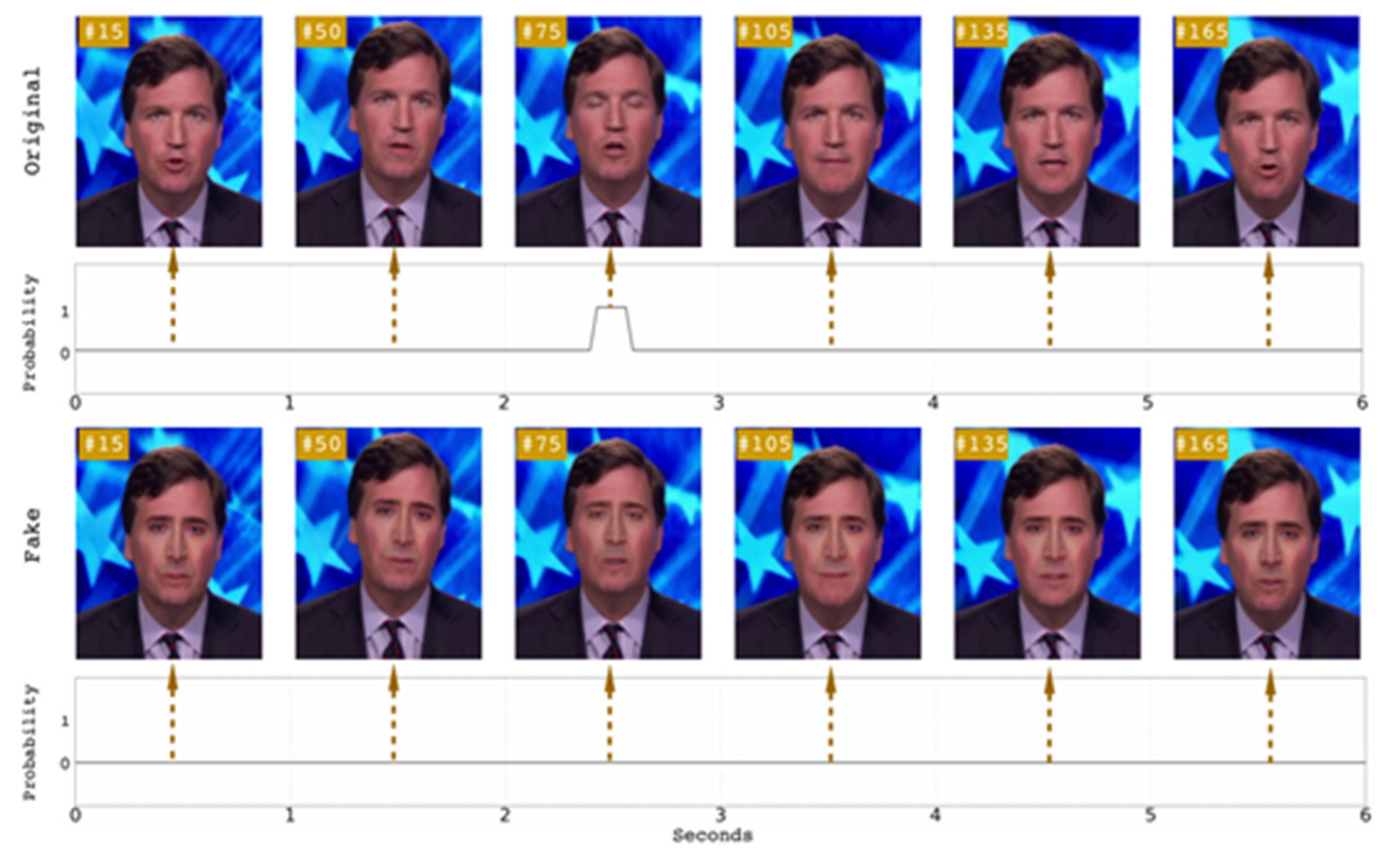

첫째는 인간의 생리적 특징을 감지하는 것이다. 딥페이크가 얼굴 이미지를 바꿀 때 기초적인 형태 이외에 안색이나 얼굴 그림자와 같은 신체적 특징을 제대로 반영하지 못하는 점을 활용해 조작 여부를 판별한다. 가령, 미국 뉴욕올버니대학교(State University of New York at Albany)의 시웨이 류(Siwer Lyu) 교수팀은 2018년 6월 눈 깜빡임을 통해 딥페이크 영상을 판별하는 방안을 제안한 바 있다.[4] 연구팀에 따르면 딥페이크가 스틸 이미지를 기반으로 사람들의 얼굴을 학습하기 때문에 합성 영상에서는 눈을 깜빡이는 것과 같은 생리학적 신호가 잘 나타나지 않으며, 나타나더라도 동작이 매우 부자연스럽다고 한다. 가령, 아래 그림에서 보듯 대개 6초 이내에 한 번은 발생하게 되는 눈 깜빡임이 딥페이크 합성 영상에서는 나타나지 않는다. 류 교수팀은 이와 같은 신호를 자동으로 탐지하는 알고리즘을 적용함으로써 영상의 조작 여부를 판별할 수 있다고 밝혔다.

2020년 인텔이 미국 빙햄톤대학교(Binghamton University)와 공동으로 개발한 기술도 이런 유형에 속한다.[5] 피부에 빛을 비춰 혈류 흐름을 관찰하는 ‘PPG (photoplethysmography)’기술을 활용해 딥페이크 영상을 탐지하는 것이다. 해당 기술은 영상에 등장하는 사람 얼굴의 32개 지점에서 생체 신호를 측정해 불일치나 노이즈를 확인함으로써 조작 여부를 판단한다. 인텔은 이 기술이 테스트 환경에서 딥페이크 영상에 대해 97.3퍼센트의 탐지 정확도를 보였다고 발표했다.

둘째는 딥페이크 합성 이미지에서만 발견되는 독특한 흔적(artifacts)을 찾아내는 것이다. 현재 딥페이크 알고리즘은 제한된 해상도의 이미지밖에 생산할 수 없다. 따라서 원본 영상에 나오는 원래 얼굴과 가짜 얼굴을 매치하기 위해 추가적인 변경이 필요하다. 이러한 변형의 결과로 딥페이크 영상에는, 인간의 시각으로는 구분할 수 없지만, 숨길 수 없는 흔적이 남게 된다. 가령, 아래 그림[6]에서 여성의 머리와 자동차 지붕, 말의 뒤편에 있는 반점은 합성 이미지에서만 뚜렷하게 발견할 수 있는 흔적이다. 많은 연구자들은 이 흔적을 식별하는 알고리즘을 개발해 영상의 원본성을 확인하고, 딥페이크 조작 여부를 판별한다. 이러한 흔적은 특히 이미지 분석에 특화된 인공신경망의 유형인 ‘컨볼루션 신경망(CNN)’을 통해 효과적으로 포착할 수 있기 때문에 딥페이크의 기반 기술인 생성적 적대 신경망을 활용하는 것보다 작업 속도가 빠르고, 컴퓨터가 처리해야 하는 계산량도 적다. 실제 테스트에서도 합성 영상 식별율이 높은 것으로 나타나 딥페이크 탐지 기술의 효율성을 높인 것으로 평가된다.[7]

셋째는 주파수(frequency) 기반의 감지 방법이다. 이미지는 크게 공간 영역(spatial domain)과 변환 영역(transform domain)으로 구분된다. 공간 영역은 우리에게 익숙한 화소(pixel)로 표현되고, 변환 영역은 화소 밝기의 변화 등이 푸리에 변환 (Fourier Transform)을 통해 주파수의 변동계수 (coefficient)로 표현된다. 이미지 경계나 객체의 모서리처럼 색상이나 밝기가 자주 변화하는 영역은 주파수가 높고 배경이나 객체 내부처럼 색상이나 밝기가 거의 변하지 않는 영역은 주파수가 낮다. 아래 그림에서 보듯, 고주파 영역에서는 진짜 이미지와 딥페이크 이미지의 파워 스펙트럼이 확연한 차이를 보이기 때문에 이를 활용해 원본성을 판별할 수 있다.[8] 이러한 방식은 딥페이크 이미지의 ‘병합’ 단계가 ‘추출’이나 ‘합성’ 단계에 비해 ANN 을 활용하지 않고 상대적으로 덜 정교하다는 특징을 이용한 것이다.

둘째는 딥페이크 합성 이미지에서만 발견되는 독특한 흔적(artifacts)을 찾아내는 것이다. 현재 딥페이크 알고리즘은 제한된 해상도의 이미지밖에 생산할 수 없다. 따라서 원본 영상에 나오는 원래 얼굴과 가짜 얼굴을 매치하기 위해 추가적인 변경이 필요하다. 이러한 변형의 결과로 딥페이크 영상에는, 인간의 시각으로는 구분할 수 없지만, 숨길 수 없는 흔적이 남게 된다. 가령, 아래 그림[6]에서 여성의 머리와 자동차 지붕, 말의 뒤편에 있는 반점은 합성 이미지에서만 뚜렷하게 발견할 수 있는 흔적이다. 많은 연구자들은 이 흔적을 식별하는 알고리즘을 개발해 영상의 원본성을 확인하고, 딥페이크 조작 여부를 판별한다. 이러한 흔적은 특히 이미지 분석에 특화된 인공신경망의 유형인 ‘컨볼루션 신경망(CNN)’을 통해 효과적으로 포착할 수 있기 때문에 딥페이크의 기반 기술인 생성적 적대 신경망을 활용하는 것보다 작업 속도가 빠르고, 컴퓨터가 처리해야 하는 계산량도 적다. 실제 테스트에서도 합성 영상 식별율이 높은 것으로 나타나 딥페이크 탐지 기술의 효율성을 높인 것으로 평가된다.[7]

셋째는 주파수(frequency) 기반의 감지 방법이다. 이미지는 크게 공간 영역(spatial domain)과 변환 영역(transform domain)으로 구분된다. 공간 영역은 우리에게 익숙한 화소(pixel)로 표현되고, 변환 영역은 화소 밝기의 변화 등이 푸리에 변환 (Fourier Transform)을 통해 주파수의 변동계수 (coefficient)로 표현된다. 이미지 경계나 객체의 모서리처럼 색상이나 밝기가 자주 변화하는 영역은 주파수가 높고 배경이나 객체 내부처럼 색상이나 밝기가 거의 변하지 않는 영역은 주파수가 낮다. 아래 그림에서 보듯, 고주파 영역에서는 진짜 이미지와 딥페이크 이미지의 파워 스펙트럼이 확연한 차이를 보이기 때문에 이를 활용해 원본성을 판별할 수 있다.[8] 이러한 방식은 딥페이크 이미지의 ‘병합’ 단계가 ‘추출’이나 ‘합성’ 단계에 비해 ANN 을 활용하지 않고 상대적으로 덜 정교하다는 특징을 이용한 것이다.

학계뿐만 아니라 상당수의 기업도 딥페이크 탐지 기술 개발에 적극적으로 참여하고 있다. 온라인 데이터 분석 및 예측 플랫폼인 ‘캐글(Kaggle)’이 2019년 개최한 대회, ‘딥페이크 식별 챌린지(Deepfake Detection Challenge)’가 대표적이다.[9] 총 상금 100만 달러가 걸린 이 대회는 딥페이크가 활용된 조작 미디어를 식별하는 신기술 개발을 촉진하기 위해 시작됐다. 페이스북, MS, AWS 등 13개국, 100여 개 파트너들이 결성한 ‘AI의 미디어 무결성 운영위원회 파트너십(Partnership on AI)’을 중심으로 대회가 꾸려졌다. 파트너십에 소속된 기업들이 학습 데이터를 제공했고 2114명의 참가자가 총 3만 5109개의 탐지 모델을 제작하여 출품했다. 제출된 모델들의 평균 조작 이미지 식별률은 70퍼센트였으며, 최고는 83퍼센트에 달했다.

이보다 앞선 2018년에는 GIF 이미지 플랫폼인 지피캣Gfycat이 색인을 생성해 콘텐츠를 분류, 관리하는 AI 기술을 조작된 콘텐츠를 자동으로 찾아내고 삭제하는 데도 활용한 바 있다. 이는 고양이의 이름을 딴 두 가지 프로젝트, ‘앙고라 프로젝트(Project Angora)’와 ‘마루 프로젝트(Project Maru)’를 통해 진행됐다.[10]

앙고라 프로젝트는 이용자가 업로드한 GIF 영상보다 더 해상도가 높은 GIF 영상을 웹에서 찾고 이를 자동으로 대체하는 솔루션이다. 딥페이크 합성 영상의 해상도가 그다지 높지 않기 때문에 앙고라 프로젝트가 합성 영상을 해상도가 더 나은 버전으로 자동 업데이트할 경우 합성 영상은 삭제되고 원본 영상만 플랫폼에 남게 된다.

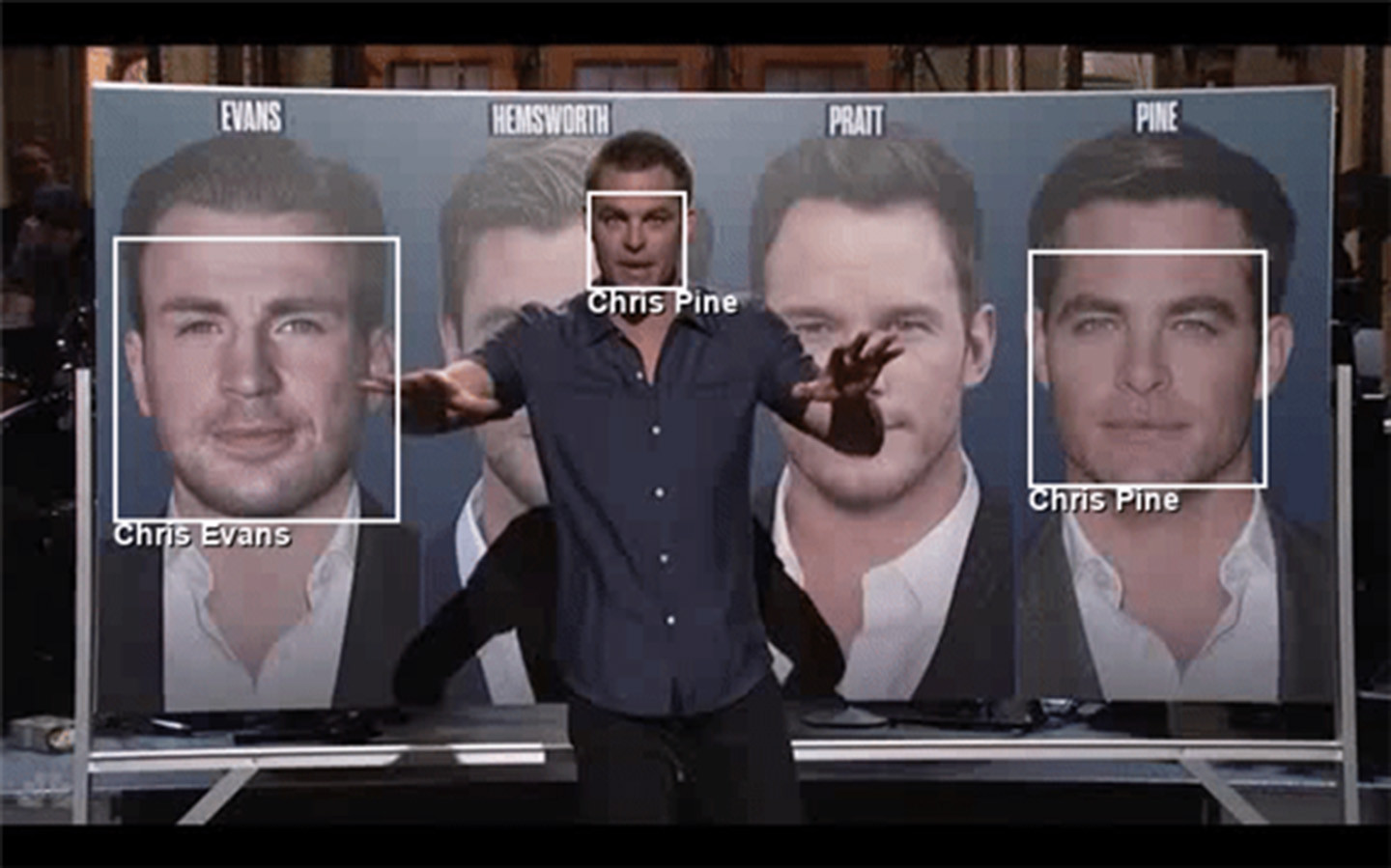

마루 프로젝트[11]는 이용자가 영상에 태그를 달지 않았을 때 AI 기술이 영상에 등장한 인물을 식별하여 자동으로 태그를 다는 솔루션이다. 딥페이크 합성 영상의 경우 얼굴 프레임이 완전히 맞지 않기 때문에 마루 프로젝트가 태그를 달기 위해 얼굴을 식별하는 과정에서 해당 영상의 조작 가능성을 탐지하게 된다. 이 경우 지피캣은 자동으로 해당 영상에서 조작이 의심되는 얼굴 부분을 가린 채 나머지 신체와 배경이 등장하는 영상을 인터넷에서 검색한다. 만약 검색 결과 얻은 원본 영상과 GIF의 얼굴이 일치하지 않으면 AI는 해당 GIF가 합성, 조작됐다는 결론을 내릴 수 있다.

딥페이크 탐지 기술을 개발하기 위한 스타트업의 노력도 활발하다. 네덜란드의 기업 딥트레이스는 바이러스 백신 소프트웨어처럼 소셜 미디어나 검색 엔진의 백그라운드에서 작동하면서 시청각 미디어를 스캔하는 딥페이크 탐지 소프트웨어를 개발한 바 있다.[12] 딥트레이스는 딥페이크를 단순한 얼굴의 교체가 아니라 인체 움직임을 모방하고 사람의 음성을 합성하는 기술로 폭넓게 정의하고 사이버 보안에 상당한 위험을 초래하는 기술로 간주한다. 딥트레이스는 바이러스 백신 프로그램처럼 딥페이크에 항시 대응 가능한 시스템을 기존의 사용 환경 위에서 구축하는 것이 중요하다고 강조하면서 기존 플랫폼의 인터페이스와 데이터 파이프라인을 활용하는 등, 플랫폼과 통합할 수 있는 형태의 탐지 기술을 만드는 중이다. ‘트루픽(Truepic)’[13]이나 ‘세릴레이(Serelay)’[14]와 같은 스타트업 또한 이미지 캡쳐 시 대상 이미지의 진위 여부를 확인할 수 있도록 하는 응용 프로그램을 구체화하고 있다.

이보다 앞선 2018년에는 GIF 이미지 플랫폼인 지피캣Gfycat이 색인을 생성해 콘텐츠를 분류, 관리하는 AI 기술을 조작된 콘텐츠를 자동으로 찾아내고 삭제하는 데도 활용한 바 있다. 이는 고양이의 이름을 딴 두 가지 프로젝트, ‘앙고라 프로젝트(Project Angora)’와 ‘마루 프로젝트(Project Maru)’를 통해 진행됐다.[10]

앙고라 프로젝트는 이용자가 업로드한 GIF 영상보다 더 해상도가 높은 GIF 영상을 웹에서 찾고 이를 자동으로 대체하는 솔루션이다. 딥페이크 합성 영상의 해상도가 그다지 높지 않기 때문에 앙고라 프로젝트가 합성 영상을 해상도가 더 나은 버전으로 자동 업데이트할 경우 합성 영상은 삭제되고 원본 영상만 플랫폼에 남게 된다.

마루 프로젝트[11]는 이용자가 영상에 태그를 달지 않았을 때 AI 기술이 영상에 등장한 인물을 식별하여 자동으로 태그를 다는 솔루션이다. 딥페이크 합성 영상의 경우 얼굴 프레임이 완전히 맞지 않기 때문에 마루 프로젝트가 태그를 달기 위해 얼굴을 식별하는 과정에서 해당 영상의 조작 가능성을 탐지하게 된다. 이 경우 지피캣은 자동으로 해당 영상에서 조작이 의심되는 얼굴 부분을 가린 채 나머지 신체와 배경이 등장하는 영상을 인터넷에서 검색한다. 만약 검색 결과 얻은 원본 영상과 GIF의 얼굴이 일치하지 않으면 AI는 해당 GIF가 합성, 조작됐다는 결론을 내릴 수 있다.

딥페이크 탐지 기술을 개발하기 위한 스타트업의 노력도 활발하다. 네덜란드의 기업 딥트레이스는 바이러스 백신 소프트웨어처럼 소셜 미디어나 검색 엔진의 백그라운드에서 작동하면서 시청각 미디어를 스캔하는 딥페이크 탐지 소프트웨어를 개발한 바 있다.[12] 딥트레이스는 딥페이크를 단순한 얼굴의 교체가 아니라 인체 움직임을 모방하고 사람의 음성을 합성하는 기술로 폭넓게 정의하고 사이버 보안에 상당한 위험을 초래하는 기술로 간주한다. 딥트레이스는 바이러스 백신 프로그램처럼 딥페이크에 항시 대응 가능한 시스템을 기존의 사용 환경 위에서 구축하는 것이 중요하다고 강조하면서 기존 플랫폼의 인터페이스와 데이터 파이프라인을 활용하는 등, 플랫폼과 통합할 수 있는 형태의 탐지 기술을 만드는 중이다. ‘트루픽(Truepic)’[13]이나 ‘세릴레이(Serelay)’[14]와 같은 스타트업 또한 이미지 캡쳐 시 대상 이미지의 진위 여부를 확인할 수 있도록 하는 응용 프로그램을 구체화하고 있다.

상술한 기술들이 딥페이크 탐지를 위한 완벽한 기술은 아니다. 눈 깜빡임을 활용한 탐지 기술은 딥페이크가 이미지를 학습하는 과정에 눈을 감은 이미지를 추가하는 것으로 쉽게 우회할 수 있고, 픽셀 불일치나 낮은 해상도처럼 딥페이크 영상의 조악한 품질을 활용한 탐지 기술은 딥페이크가 더 많은 이미지를 학습하면서 무력화될 가능성이 크다. 해당 탐지 기술이 해상도나 품질이 낮은 이미지에만 제한적으로 작동할 수 있다는 뜻이다. 지피캣의 앙고라, 마루 프로젝트는 원본 영상이 없으면 조작 여부에 대한 식별이 불가능하다는 한계를 가진다. 즉, 지피캣의 프로젝트는 수많은 중복 이미지가 웹을 떠도는. 유명인사의 영상 탐지에 특화돼 있다. 만약 유명인사가 아닌 일반인이 동영상을 찍고 웹이 아닌 로컬 장치에 저장해 둔 이미지를 활용해 상대의 얼굴을 바꿔치기한 후 결과물을 온라인에 업로드하면 앙고라와 마루 중 어떤 알고리즘도 내용의 변경 여부를 탐지할 수 없다. 현재는 딥페이크 기술 적용을 위해 온라인상의 이미지를 학습에 활용하기 때문에 이런 문제가 발생할 가능성이 작지만, 딥페이크 기술과 개별 이미지 저장 장치의 발달과 함께 문제의 가능성은 커질 것이다. 알고리즘이 출시되기 전에 업로드된 모든 콘텐츠에 대해 기술을 적용하기 어렵다는 한계도 극복해야 하는 과제다.[15]

딥페이크 탐지 기술은 지금도 여러 연구팀에 의해 개발되고 있으며, 앞으로 더욱 발전할 것으로 기대된다. 그러나 변치 않을 문제는 탐지 기술이 늘 생산 기술에 뒤처질 수밖에 없다는 점이다. 악용은 언제나 대응에 앞서기에, 딥페이크 이용자는 어떤 식으로든 탐지 소프트웨어를 우회할 가능성이 크다. 아울러 기술적 해결책은 활용되지 않으면 결국 무용지물이 되고 만다. 현재 콘텐츠 공유 환경의 분산성을 고려할 때 일부 딥페이크 영상은 필연적으로 탐지 소프트웨어를 거치지 않고 이용자에게 가닿을 것이고, 이러한 사례들은 탐지 기술을 무력화할 것이다.

모든 딥페이크 영상이 악의적인 것은 아니라는 점에서도 기술적 대응의 효용을 다시 평가할 필요가 있다. 딥페이크가 만들어 낸 합성 포르노 영상은 명백하게 악의적이고 반사회적이다. 그러나 동시에 몇몇 창작 영상은 정치적 논평이나 풍자의 기능을 수행할 수 있다. 앞선 사례에서 보았듯, 언론 인터뷰나 내부자 제보를 위해 영상 내 특정인의 얼굴을 일부러 가려야 하는 경우도 존재한다. 이 경우에도 모두 딥페이크 탐지 기술이 자동으로 적용되는 것이 옳을까? 이용자 신고 방식과 달리 기술적 대응은 딥페이크가 합성한 영상의 ‘내용’에는 신경을 쓰지 않는다. 영상의 속성 외 다른 메타 데이터를 활용하거나 탐지 기술과 인간의 개입을 적절히 혼용하는 등의 노력이 필요한 것은 이 때문이다.

이처럼 무조건 딥페이크 탐지를 자동화하는 것만이 능사는 아니며, 기술적 대응이 딥페이크 이슈에 대한 완전한 해결책이라고 하기도 어렵다. AI 기술을 활용하여 AI 기술에 기반을 둔 딥페이크에 대응하는 것은 끊임없이 쫓고 쫓기는 게임, 그것도 쫓는 자의 승률이 현저히 낮은 게임이 될 수밖에 없다. 다만, 한 가지 확실한 것은 딥페이크 탐지 기술이 영상 조작을 매우 어렵고 시간이 소요되는 작업으로 만들 수는 있다는 점이다. 이 점에서 딥페이크 탐지 기술은 악의적 딥페이크 기술에 대한 대응으로서 충분히 가치를 지니며, 딥페이크 기술과 함께 탐지 기술이 어떻게 발전하는지를 눈여겨볼 필요가 있다.

법령 및 가치 충돌의 딜레마

딥페이크로 인한 명예훼손이나 허위정보의 문제가 확산하면서 이에 대응할 수 있는 법률적 방안 [16]에 대한 논의도 활발히 이뤄지고 있다. 전문가들은 현행법상 저작권(copyright)이나 퍼블리시티권(right of publicity), 명예훼손이나 개인 정보 침해, 성희롱에 관한 법률 등으로 딥페이크가 초래하는 문제에 대응할 수 있다고 말한다. 예를 들어 딥페이크 합성 영상이 포르노물일 경우 대부분 플랫폼의 이용 약관에 따라 콘텐츠 삭제를 즉시 요청할 수 있다. 합성 영상이 내용 면에서 크게 문제가 없더라도 사전 동의 없이 자신의 이미지를 상업적 혹은 불법적인 목적으로 사용했다는 것을 이유로 소송을 제기할 수 있다.

국내에서는 딥페이크로 다른 사람의 얼굴을 사용해 영상을 제작하는 경우 초상권 침해로 고소를 당하거나 정보통신망 이용 촉진 및 정보보호 등에 관한 법률 제70조(거짓 사실 유포와 명예 훼손)에 의거해 처벌될 수 있다. 딥페이크를 포르노 합성에 사용하는 경우, 국내에서는 포르노 동영상 제작 자체가 불법이기에 형법 제244조(음화 제조 등)에 따라 제작 및 배포, 소지 자체로도 처벌을 받을 수 있다.

미국의 경우 연방상표법(Lanham Act) 제43조를 딥페이크로 인한 허위 영상 유통에 적용할 수 있을 것이다. 연방상표법 제43조는 부정 경쟁을 규제하기 위한 조문이지만 사업자 간 경쟁 관계를 넘어 특정인이 유명인의 명성을 상업적으로 도용하거나 악의적으로 패러디함으로써 이득을 얻는 행위를 막는 근거로 활용되는데, 딥페이크를 통한 영상 조작을 악의적 패러디나 초상권 도용과 같은 행위로 규정해 이를 적용해 볼 수 있다.

주목할 점은 딥페이크로 인한 사회 문제에 대응하기 위해 별도의 법안을 제정하려는 시도 또한 진행되고 있다는 점이다. 우리나라에서는 2020년에 딥페이크 관련 법률이 개정, 강화되었다. 대표적으로 국가인권위원회가 ‘인공지능 산업 진흥에 관한 법률안’(2020)에서 딥페이크를 활용한 불법 음란 영상물이 인간의 존엄성에 심각한 위협이 될 수 있음을 보여 주는 사례라 밝힌 바 있다. 성폭력 범죄의 처벌 등에 관한 특례법에 제14조의2가 신설돼 (2020년 3월 5일 국회 본회의 통과, 6월 25일부터 시행) 딥페이크 기술을 이용해 음란물을 만들거나 배포하는 경우 처벌할 수 있는 근거가 마련되기도 했다.

미국의 경우 연방정부 차원에서 딥페이크 규제를 위한 법안이 여럿 제출됐으나 통과되지는 못한 상태다. 대표적으로, 2018년 12월 21일 벤 사세(Ben Sasse) 상원 의원이 최초로 딥페이크의 악의적 영상 생성 및 유통을 범죄로 규정하는 법안인 ‘악의적 딥페이크 금지법(Malicious Deep Fake Prohibition Act of 2018)’을 의회에 제출한 바 있다.[17] 이 법안은 “상거래 수단이나 시설을 사용하여 불법으로 배포할 의도 또는 연방, 주 또는 지방 법률에 따른 불법 행위를 조장할 의도로 딥페이크를 만드는 행위”를 불법으로 규정하고 있다. 법안은 딥페이크 영상의 생산자뿐 아니라 페이스북과 같은 유통 플랫폼의 책임도 묻고 있다. 구체적으로, 딥페이크 기술을 활용해 인터넷으로 불법적 행위를 하는 개인뿐 아니라 유통 플랫폼이 딥페이크를 유통하고 있음을 ‘인지하는’ 경우도 벌금이나 2년 이하의 징역을 부과할 수 있다는 내용을 담고 있다. 딥페이크가 폭력을 조장하거나 정부 또는 선거를 방해하는 경우 처벌 수위는 최대 10년으로 늘어난다.[18]

이 법안이 의회 통과에 실패한 이유는 해당 법안들이 여러 측면에서 기존의 가치와 충돌하거나 새로운 문제를 야기할 가능성이 크기 때문이다.[19] 전문가들은 ‘악의적 딥페이크 금지법’이 이미 법으로 금지된 행위를 다시 범죄로 만드는 법률에 불과하다고 비판한다. 유언비어를 퍼트려 선거를 방해하거나, 없는 사실로 정적(政敵)을 음해하는 일은 어떤 도구를 사용했든 그 본질은 동일하고, 이미 연방・주・지방 법률에 따른 민사나 형사 소송을 통해 처벌이나 구제가 가능한 사안이라는 것이다. 이미 범죄 또는 불법 행위로 규정된 사안을 굳이 딥페이크라는 ‘수단’에 초점을 맞춰 별도의 연방 형사법을 추가할 필요가 없다는 지적이다. 아울러 딥페이크 영상의 배포자에게 과도한 책임이 부과된 데 대한 우려도 상당하다. 영상 플랫폼이 처벌을 두려워해 딥페이크라고 신고, 보고된 모든 대상을 즉각 삭제해 버릴 때 발생할 수 있는 부작용을 생각해야 한다는 것이다.

2019년 6월 미국 하원에 발의된 ‘딥페이크 책임법안(DEEP FAKES Accountability Act)’ 역시 최종적으로 의회를 통과하지 못하고 폐기됐다. 해당 법안은 다른 사람의 신분을 사칭할 수 있는 기술적으로 조작된 온라인 콘텐츠, 즉 딥페이크 영상을 만드는 자에게 영상 제작자가 누구인지 밝히는 디지털 워터마크의 사용을 의무화하고, 해당 영상이 조작된 것임을 글이나 소리를 통해 명확하게 고지하도록 하는 것이 주요 내용이다. 딥페이크가 일으킬 수 있는 부작용을 생각하면 당장 법으로 만들어 시행해야 할 것 같지만, 딥페이크의 긍정적인 활용 방안을 생각하면 이 법안에도 미묘한 구석이 있다. 예를 들어 딥페이크로 합성된 배우가 나오는 영화에서 배우가 나오는 장면마다 제작자의 로고가 나타나거나 ‘이 배우의 얼굴은 딥페이크로 합성된 것입니다’라는 자막이 깜빡인다면, 우리는 영화에 몰입할 수 있을까. 영화의 처음과 마지막에만 표시하는 방안도 고려할 수 있겠지만 이 경우 고지 자체의 효과를 기대하기 어렵다. 영상을 건너뛰면서 핵심 장면만 찾아보는 사람들에게는 영상의 앞 또는 뒤에 있는 딥페이크 고지가 눈에 띄지 않을 것이기 때문이다.

이러한 이유로 미국에서 딥페이크에 대한 법제도적 대응은 주 단위로, 한시적 형태로 이뤄진다. 선거처럼 딥페이크로 인한 허위정보의 사회적 폐해가 명백하게 예상되는 경우에 한하는 것이다. 가령, 미국 캘리포니아주는 2019년 9월에 미국에서 처음으로 2023년까지 한시적으로 딥페이크를 규제할 수 있도록 선거법을 개정했다. 공직 후보를 선출하기 위한 선거일로부터 60일 이내에 실제 악의를 갖고(with actual malice) 후보자의 명예를 훼손하거나, 유권자의 투표 행위를 기만하려는 의도를 갖고 제작된 기만적인 오디오․비주얼 미디어를 배포하지 못하도록 하는 것이 주요 내용이다. 흥미로운 것은 이 법이 딥페이크라는 용어를 사용하지 않고 있음에도 실제 내용은 딥페이크에 기반을 둔 조작 영상물을 대상으로 한다는 점이다. 이 법이 가리키는 ‘기만적인(materially deceptive) 오디오·비주얼 미디어’의 조건은 다음 두 가지다. 첫째, 해당 정보가 허위임에도 합리적인 사람에게는 진실처럼 보여야 하며, 둘째, 합리적인 사람이 실제 정보를 듣거나 볼 경우와 비교할 때, 해당 정보가 합리적인 사람들에게 실제 정보와 근본적으로 다른 이해나 인상을 줘야 한다. 해당 법이 적용된 이후 ‘임프레션스 (Impressions)’나 ‘리페이스(Reface)’와 같은 딥페이크 제작 애플리케이션에서 일부 기능이 삭제되기도 했다. 그 때문인지 추가 개정을 거쳐 지금은 적용 기한이 2027년 1월 1일까지로 연장됐다.

유럽연합은 2022년 초대형 온라인 플랫폼과 검색 엔진에 딥페이크로 인한 피해가 발생하지 않게 하는 조치를 의무화하는 ‘디지털서비스법(Digital Service Act)’을 도입했다. 이 법에 따르면 월 활성 이용자가 4500만 명(EU 인구의 10퍼센트) 이상인 온라인 플랫폼과 검색 엔진은 실제 사람·사물·장소 등과 매우 흡사하거나 허위로 사람을 실물처럼 보이게 하는 조작된 이미지·오디오·비디오와 같은 정보에 대해서는 사용자들이 그것이 조작되었다는 것을 쉽게 알 수 있도록 분명한 식별 조치를 해야 한다. 만일 이 의무를 지키지 않았을 경우 전 세계 매출액의 6퍼센트 내에서 벌금형을 선고받을 수 있다.[20]

중국은 2023년 1월부터 ‘인터넷 정보 서비스 딥 합성 관리 규정’을 통해 세계 주요국 중에서는 처음으로 딥페이크 기술에 대한 전면적 규제를 시도하고 있다. 경제 또는 국가 안보를 어지럽힐 수 있는 정보를 확산시키기 위한 목적으로, AI를 통해 만들어진 콘텐츠의 사용은 애초에 금지된다. 어떤 목적에서든 딥페이크를 이용해 만들어진 영상은 딥페이크 영상임을 명확하게 알려야 하고 원본을 추적할 수 있도록 워터마크도 넣어야 한다. 누군가의 얼굴이나 목소리를 합성하려면 당사자의 동의를 구해야 한다. 심지어 언론사에서 보도 목적으로 딥페이크 기술을 사용하려면 영상의 원본으로 정부가 승인한 매체만 활용할 수 있다. 사실상 딥페이크 기반의 정책 풍자나 비판을 막은 것이다.[21]

이처럼 법 제도적 대응은 딥페이크를 적용한 결과물이 저지르는 범법 행위에 대해 현행 법률을 적용하거나, 딥페이크를 겨냥해 특화 법률의 제정을 시도하는 방향으로 이뤄지고 있다. 첫 번째 방식과 관련해 제기되는 문제는 저작권이나 퍼블리시티권, 명예훼손법과 같은 현행 법률이 딥페이크가 야기하는 사회 문제를 과연 얼마나 해결할 수 있는가에 대한 의문이다. 사실 이 물음은 딥페이크가 등장하기 이전부터 디지털 저작물과 관련하여 끊임없이 제기되어 왔던 문제다. 디지털 저작물에 대한 권리와 이의 공정 이용(fair use), 개인의 명예 보호와 창작 자율성 사이의 해묵은 긴장 관계를 딥페이크의 사례에서도 다시금 확인하게 되는 것이다. 특히 디지털 저작물에 의한 피해에 대응하는 것은 미국의 수정헌법 제1조(First Amendment)로 대표되는, 표현의 자유의 가치와 충돌할 수 있다. 악의적 딥페이크를 범죄화하는 것은 정치적 패러디까지 자동으로 삭제, 제한하는 행위로 이어져 새로운 논란을 야기할 수 있으며, 이 점에서 법적 대응을 위해서는 사례별 접근과 판단이 중요한 변수로 작동하게 된다.

더 큰 문제는 판결 결과가 무엇이든, 판결이 내려지기 전에 이미 딥페이크 영상은 대량으로 널리 유통됐을 것이라는 사실이다. 특히 퍼블리시티권 등이 유명인사에게 주로 유리하게 작동하고, 일반인의 경우 적용하기까지 적지 않은 노력이 소요된다는 점에서 현행 법률이 딥페이크에 대한 실제적 대응력을 갖추기는 어려워 보인다. 딥페이크를 활용한 리벤지 포르노물이 유포되는 경우에도 피해자는 그 사실 자체를 아예 모를 가능성이 높으며, 안다 해도 처벌을 기대하기가 어려운 게 현실이다.

그렇다면, 미국의 의원들이 제출한 법안들이 그 대안이 될 수 있을까? ‘악의적 딥페이크 금지법’이나 DSA의 사례에서 보듯, 이 법안들은 여러 측면에서 기존의 가치와 충돌하거나 새로운 문제를 가져올 가능성이 있다. 특히 플랫폼과 같은 딥페이크 영상 배포자에게 책임을 부과하는 방식은 미국의 통신품위법(Communications Decency Act) 제230조와 같은, 인터넷에서의 표현의 자유를 신장시켜 온 법률과 배치된다.

통신품위법 230조는 인터넷 서비스 사업자(ISP·Internet service provider)가 자신이 중개한 표현에 대해 발행인으로서 책임을 질 필요 없이 완전 면책되도록 규정한 법이다. 인터넷 서비스 사업자가 온라인상의 표현에 법적 책임을 부담하게 될까 두려워 표현을 삭제하는 일이 없도록 한 것이다. 물론 이러한 면책 조항이 피해자의 명예보다는 표현의 자유 보호만을 중시해 인터넷 사업자가 유해한 표현을 차단할 동기를 없애 버리는 부작용이 있었던 것은 사실이다. 하지만 딥페이크를 대상으로 한 새로운 플랫폼 규제 법안은 표현의 자유를 침해하고 인터넷 사업자에 과도한 책임을 부과하는 부작용을 낳을 수 있다. 딥페이크에 의한 위협에 대응하기 위한 시도가 도리어 온라인 생태계에 의도치 않은 피해를 줄 수도 있다는 점을 간과할 수는 없는 노릇이다.

이처럼 딥페이크에 대한 법적 대응은 이미 존재하는 법률과 중복되거나, 다른 법률적 가치와 충돌하는 문제와 관련되기 쉽다. 딥페이크의 피해자를 보호하는 것은 표현의 자유를 침해할 수 있고, 표현의 자유를 보장하기 위해 딥페이크 피해자 보호의 수위를 낮추면 딥페이크의 위해성이 가늠할 수 없는 수준으로 커져 버리는 것이다.

이러한 긴장을 조정하는 것은 법원의 역할이지만, 실질적인 법적 구제 수단이 있더라도 딥페이크가 초래하는 위험에 충분히 대응하기 위해 새로운 논의 또한 진행돼야 한다는 사실만큼은 분명하다. 새로운 법률이 만들어진다 해도 이것이 사후적인 대응일 수밖에 없다는 점은 해결할 수 없는 한계이기 때문이다. 법적 유효성이 높다 해도 법은 피해가 일어난 다음에야 작동한다. 법률 바깥의 대응이 필요한 이유다.

기술 자체보다 기술이 야기하는 문제들에 관심을

딥페이크가 초래하는 위험에 대응하기 위해 산업적, 기술적, 법적으로 다양한 노력이 이루어지고 있지만, 딥페이크가 지니는 잠재적 위협이 모두 제거된 것은 아니다. 어떤 방법도 딥페이크가 불러 오는 문제에 대한 완전하고도 유일한 해결책이 될 수 없기에, 딥페이크 기술과 영향력에 대해 지속적으로 관심을 가지고 이해도를 높이는 것이 근본적인 대응 방안이라는 목소리가 점차 커지고 있다.

이와 관련하여 MIT 미디어 연구소와 하버드대학교 버크만 센터 ‘AI 윤리와 거버넌스 이니셔티브 (the Ethics and Governance of AI Initiative)’의 팀 황(Tim Hwang)은 실제 발생하는 구체적이고 개별적인 딥페이크 문제에 관심을 가지고 이에 대한 해결책을 마련하는 데 집중하는 것이 딥페이크 탐지 알고리즘을 개발하는 것보다 더 중요하다고 강조한다.[22] 자동화된 탐지 도구와 이의 산업적 적용, 가능한 문제들에 대한 법적 대응이 어디까지나 관련된 사람들의 폭넓은 이해와 관심 속에서 이뤄져야 한다는 뜻이다. 그는 기술과 인간 간 균형이 딥페이크에 대한 대응의 핵심이라고 봤다. 가령, 저널리스트나 리포터가 악의성 여부를 판단하기 어려운 애매한 경우나 딥페이크가 적용되는 특수한 맥락에 대한 사례를 제공해 줄 때 기술자와 연구자는 해당 기술의 원리와 활용을 보다 구체적으로 고민할 수 있을 것이다.

같은 맥락에서 전 사회적으로 딥페이크 기술과 딥페이크의 영향력에 대한 이해를 높이는 것이 딥페이크로 인한 부작용을 최소화하는 데 기여할 수 있다. 이와 관련해서는 노엘 마틴(Noelle Martin)이라는 한 여성의 사례에 주목해 볼 만하다. 마틴은 대학생이 된 후 소셜 미디어에 올린 자신의 이미지가 딥페이크 조작에 활용되어 포르노 DVD 표지로 만들어지고 포르노 사이트에 게시, 유통된 것을 알게 된다. 여기에는 심지어 마틴이 미성년자였을 때의 사진이 아동 포르노물과 합성된 경우도 있었다. 대다수의 피해자가 이러한 경우에 대해 쉬쉬하고 넘어간 것과 달리 노엘은 이에 공식적으로 대항하는 활동을 약 10년 간 지속해 오고 있다. 가해자의 신원을 모르는 상황에서 마틴은 가해자를 처벌하는 대신 법을 바꾸고자 결심했다. 마틴은 테드 강연(Ted Talk) 등을 통해 딥페이크로 인해 자신이 경험한 피해를 이야기하면서[23] 법령 제정의 필요성에 대해 역설했고, 이러한 활동은 호주에서 적대적 포르노에 대한 법률이 제정되는 데 영향을 미치는 등 실질적인 효과를 가져왔다. 포기를 거부한 그녀의 태도와 행동은 딥페이크와 그로 인한 여성 대상의 폭력과 위협의 이슈를 환기하고 피해자의 지위를 법적으로 회복하는 데 기여했다고 평가받는다.[24]

이처럼, 딥페이크가 초래하는 위협에 대응하기 위해서는 광범위한 문화적 변화가 필요하다. 특히, 피해자들의 침묵보다는 행동이, 사회적 무지보다는 관심이, 대중의 흥미보다는 인식의 향상이 중요하다. 딥페이크로 인해 영상이 조작될 수 있다는 사실, 조작된 영상 때문에 피해를 입은 사람이 어딘가에 존재할 수 있다는 사실, 이를 신고하면 삭제 등의 조치가 취해질 수 있다는 사실을 아는 사람이 많아질수록 딥페이크에 대한 사회적 대응책의 힘은 강해질 수 있다.

‘ASI 데이터 사이언스(ASI Data Science)’의 연구원 존 깁슨(John Gibson)은 2018년 열린 제15회 얄타 유럽 전략 회의(Yalta European Strategy)에서 영상과 음성 합성 기술의 가능성에 대한 사람들의 인식을 제고하는 것이 중요함을 역설한 바 있다. 그는 딥페이크를 ‘램프에서 빠져나온 지니’에 비유하면서, 영상 합성 기술이 앞으로 대중들에 의해 더 많이 이용될 것이고 이러한 발전을 정부가 통제할 수는 없을 것이라 전망했다. 깁슨은 정부의 통제 대신 허위정보의 영향을 완화하는 방향으로 해결책이 집중되는 것이 중요하며, 그중 하나는 사람들이 영상의 정치적 맥락을 인식하도록 돕는 것이라고 이야기했다.

딥페이크 탐지 기술은 지금도 여러 연구팀에 의해 개발되고 있으며, 앞으로 더욱 발전할 것으로 기대된다. 그러나 변치 않을 문제는 탐지 기술이 늘 생산 기술에 뒤처질 수밖에 없다는 점이다. 악용은 언제나 대응에 앞서기에, 딥페이크 이용자는 어떤 식으로든 탐지 소프트웨어를 우회할 가능성이 크다. 아울러 기술적 해결책은 활용되지 않으면 결국 무용지물이 되고 만다. 현재 콘텐츠 공유 환경의 분산성을 고려할 때 일부 딥페이크 영상은 필연적으로 탐지 소프트웨어를 거치지 않고 이용자에게 가닿을 것이고, 이러한 사례들은 탐지 기술을 무력화할 것이다.

모든 딥페이크 영상이 악의적인 것은 아니라는 점에서도 기술적 대응의 효용을 다시 평가할 필요가 있다. 딥페이크가 만들어 낸 합성 포르노 영상은 명백하게 악의적이고 반사회적이다. 그러나 동시에 몇몇 창작 영상은 정치적 논평이나 풍자의 기능을 수행할 수 있다. 앞선 사례에서 보았듯, 언론 인터뷰나 내부자 제보를 위해 영상 내 특정인의 얼굴을 일부러 가려야 하는 경우도 존재한다. 이 경우에도 모두 딥페이크 탐지 기술이 자동으로 적용되는 것이 옳을까? 이용자 신고 방식과 달리 기술적 대응은 딥페이크가 합성한 영상의 ‘내용’에는 신경을 쓰지 않는다. 영상의 속성 외 다른 메타 데이터를 활용하거나 탐지 기술과 인간의 개입을 적절히 혼용하는 등의 노력이 필요한 것은 이 때문이다.

이처럼 무조건 딥페이크 탐지를 자동화하는 것만이 능사는 아니며, 기술적 대응이 딥페이크 이슈에 대한 완전한 해결책이라고 하기도 어렵다. AI 기술을 활용하여 AI 기술에 기반을 둔 딥페이크에 대응하는 것은 끊임없이 쫓고 쫓기는 게임, 그것도 쫓는 자의 승률이 현저히 낮은 게임이 될 수밖에 없다. 다만, 한 가지 확실한 것은 딥페이크 탐지 기술이 영상 조작을 매우 어렵고 시간이 소요되는 작업으로 만들 수는 있다는 점이다. 이 점에서 딥페이크 탐지 기술은 악의적 딥페이크 기술에 대한 대응으로서 충분히 가치를 지니며, 딥페이크 기술과 함께 탐지 기술이 어떻게 발전하는지를 눈여겨볼 필요가 있다.

법령 및 가치 충돌의 딜레마

딥페이크로 인한 명예훼손이나 허위정보의 문제가 확산하면서 이에 대응할 수 있는 법률적 방안 [16]에 대한 논의도 활발히 이뤄지고 있다. 전문가들은 현행법상 저작권(copyright)이나 퍼블리시티권(right of publicity), 명예훼손이나 개인 정보 침해, 성희롱에 관한 법률 등으로 딥페이크가 초래하는 문제에 대응할 수 있다고 말한다. 예를 들어 딥페이크 합성 영상이 포르노물일 경우 대부분 플랫폼의 이용 약관에 따라 콘텐츠 삭제를 즉시 요청할 수 있다. 합성 영상이 내용 면에서 크게 문제가 없더라도 사전 동의 없이 자신의 이미지를 상업적 혹은 불법적인 목적으로 사용했다는 것을 이유로 소송을 제기할 수 있다.

국내에서는 딥페이크로 다른 사람의 얼굴을 사용해 영상을 제작하는 경우 초상권 침해로 고소를 당하거나 정보통신망 이용 촉진 및 정보보호 등에 관한 법률 제70조(거짓 사실 유포와 명예 훼손)에 의거해 처벌될 수 있다. 딥페이크를 포르노 합성에 사용하는 경우, 국내에서는 포르노 동영상 제작 자체가 불법이기에 형법 제244조(음화 제조 등)에 따라 제작 및 배포, 소지 자체로도 처벌을 받을 수 있다.

미국의 경우 연방상표법(Lanham Act) 제43조를 딥페이크로 인한 허위 영상 유통에 적용할 수 있을 것이다. 연방상표법 제43조는 부정 경쟁을 규제하기 위한 조문이지만 사업자 간 경쟁 관계를 넘어 특정인이 유명인의 명성을 상업적으로 도용하거나 악의적으로 패러디함으로써 이득을 얻는 행위를 막는 근거로 활용되는데, 딥페이크를 통한 영상 조작을 악의적 패러디나 초상권 도용과 같은 행위로 규정해 이를 적용해 볼 수 있다.

주목할 점은 딥페이크로 인한 사회 문제에 대응하기 위해 별도의 법안을 제정하려는 시도 또한 진행되고 있다는 점이다. 우리나라에서는 2020년에 딥페이크 관련 법률이 개정, 강화되었다. 대표적으로 국가인권위원회가 ‘인공지능 산업 진흥에 관한 법률안’(2020)에서 딥페이크를 활용한 불법 음란 영상물이 인간의 존엄성에 심각한 위협이 될 수 있음을 보여 주는 사례라 밝힌 바 있다. 성폭력 범죄의 처벌 등에 관한 특례법에 제14조의2가 신설돼 (2020년 3월 5일 국회 본회의 통과, 6월 25일부터 시행) 딥페이크 기술을 이용해 음란물을 만들거나 배포하는 경우 처벌할 수 있는 근거가 마련되기도 했다.

미국의 경우 연방정부 차원에서 딥페이크 규제를 위한 법안이 여럿 제출됐으나 통과되지는 못한 상태다. 대표적으로, 2018년 12월 21일 벤 사세(Ben Sasse) 상원 의원이 최초로 딥페이크의 악의적 영상 생성 및 유통을 범죄로 규정하는 법안인 ‘악의적 딥페이크 금지법(Malicious Deep Fake Prohibition Act of 2018)’을 의회에 제출한 바 있다.[17] 이 법안은 “상거래 수단이나 시설을 사용하여 불법으로 배포할 의도 또는 연방, 주 또는 지방 법률에 따른 불법 행위를 조장할 의도로 딥페이크를 만드는 행위”를 불법으로 규정하고 있다. 법안은 딥페이크 영상의 생산자뿐 아니라 페이스북과 같은 유통 플랫폼의 책임도 묻고 있다. 구체적으로, 딥페이크 기술을 활용해 인터넷으로 불법적 행위를 하는 개인뿐 아니라 유통 플랫폼이 딥페이크를 유통하고 있음을 ‘인지하는’ 경우도 벌금이나 2년 이하의 징역을 부과할 수 있다는 내용을 담고 있다. 딥페이크가 폭력을 조장하거나 정부 또는 선거를 방해하는 경우 처벌 수위는 최대 10년으로 늘어난다.[18]

이 법안이 의회 통과에 실패한 이유는 해당 법안들이 여러 측면에서 기존의 가치와 충돌하거나 새로운 문제를 야기할 가능성이 크기 때문이다.[19] 전문가들은 ‘악의적 딥페이크 금지법’이 이미 법으로 금지된 행위를 다시 범죄로 만드는 법률에 불과하다고 비판한다. 유언비어를 퍼트려 선거를 방해하거나, 없는 사실로 정적(政敵)을 음해하는 일은 어떤 도구를 사용했든 그 본질은 동일하고, 이미 연방・주・지방 법률에 따른 민사나 형사 소송을 통해 처벌이나 구제가 가능한 사안이라는 것이다. 이미 범죄 또는 불법 행위로 규정된 사안을 굳이 딥페이크라는 ‘수단’에 초점을 맞춰 별도의 연방 형사법을 추가할 필요가 없다는 지적이다. 아울러 딥페이크 영상의 배포자에게 과도한 책임이 부과된 데 대한 우려도 상당하다. 영상 플랫폼이 처벌을 두려워해 딥페이크라고 신고, 보고된 모든 대상을 즉각 삭제해 버릴 때 발생할 수 있는 부작용을 생각해야 한다는 것이다.

2019년 6월 미국 하원에 발의된 ‘딥페이크 책임법안(DEEP FAKES Accountability Act)’ 역시 최종적으로 의회를 통과하지 못하고 폐기됐다. 해당 법안은 다른 사람의 신분을 사칭할 수 있는 기술적으로 조작된 온라인 콘텐츠, 즉 딥페이크 영상을 만드는 자에게 영상 제작자가 누구인지 밝히는 디지털 워터마크의 사용을 의무화하고, 해당 영상이 조작된 것임을 글이나 소리를 통해 명확하게 고지하도록 하는 것이 주요 내용이다. 딥페이크가 일으킬 수 있는 부작용을 생각하면 당장 법으로 만들어 시행해야 할 것 같지만, 딥페이크의 긍정적인 활용 방안을 생각하면 이 법안에도 미묘한 구석이 있다. 예를 들어 딥페이크로 합성된 배우가 나오는 영화에서 배우가 나오는 장면마다 제작자의 로고가 나타나거나 ‘이 배우의 얼굴은 딥페이크로 합성된 것입니다’라는 자막이 깜빡인다면, 우리는 영화에 몰입할 수 있을까. 영화의 처음과 마지막에만 표시하는 방안도 고려할 수 있겠지만 이 경우 고지 자체의 효과를 기대하기 어렵다. 영상을 건너뛰면서 핵심 장면만 찾아보는 사람들에게는 영상의 앞 또는 뒤에 있는 딥페이크 고지가 눈에 띄지 않을 것이기 때문이다.

이러한 이유로 미국에서 딥페이크에 대한 법제도적 대응은 주 단위로, 한시적 형태로 이뤄진다. 선거처럼 딥페이크로 인한 허위정보의 사회적 폐해가 명백하게 예상되는 경우에 한하는 것이다. 가령, 미국 캘리포니아주는 2019년 9월에 미국에서 처음으로 2023년까지 한시적으로 딥페이크를 규제할 수 있도록 선거법을 개정했다. 공직 후보를 선출하기 위한 선거일로부터 60일 이내에 실제 악의를 갖고(with actual malice) 후보자의 명예를 훼손하거나, 유권자의 투표 행위를 기만하려는 의도를 갖고 제작된 기만적인 오디오․비주얼 미디어를 배포하지 못하도록 하는 것이 주요 내용이다. 흥미로운 것은 이 법이 딥페이크라는 용어를 사용하지 않고 있음에도 실제 내용은 딥페이크에 기반을 둔 조작 영상물을 대상으로 한다는 점이다. 이 법이 가리키는 ‘기만적인(materially deceptive) 오디오·비주얼 미디어’의 조건은 다음 두 가지다. 첫째, 해당 정보가 허위임에도 합리적인 사람에게는 진실처럼 보여야 하며, 둘째, 합리적인 사람이 실제 정보를 듣거나 볼 경우와 비교할 때, 해당 정보가 합리적인 사람들에게 실제 정보와 근본적으로 다른 이해나 인상을 줘야 한다. 해당 법이 적용된 이후 ‘임프레션스 (Impressions)’나 ‘리페이스(Reface)’와 같은 딥페이크 제작 애플리케이션에서 일부 기능이 삭제되기도 했다. 그 때문인지 추가 개정을 거쳐 지금은 적용 기한이 2027년 1월 1일까지로 연장됐다.

유럽연합은 2022년 초대형 온라인 플랫폼과 검색 엔진에 딥페이크로 인한 피해가 발생하지 않게 하는 조치를 의무화하는 ‘디지털서비스법(Digital Service Act)’을 도입했다. 이 법에 따르면 월 활성 이용자가 4500만 명(EU 인구의 10퍼센트) 이상인 온라인 플랫폼과 검색 엔진은 실제 사람·사물·장소 등과 매우 흡사하거나 허위로 사람을 실물처럼 보이게 하는 조작된 이미지·오디오·비디오와 같은 정보에 대해서는 사용자들이 그것이 조작되었다는 것을 쉽게 알 수 있도록 분명한 식별 조치를 해야 한다. 만일 이 의무를 지키지 않았을 경우 전 세계 매출액의 6퍼센트 내에서 벌금형을 선고받을 수 있다.[20]

중국은 2023년 1월부터 ‘인터넷 정보 서비스 딥 합성 관리 규정’을 통해 세계 주요국 중에서는 처음으로 딥페이크 기술에 대한 전면적 규제를 시도하고 있다. 경제 또는 국가 안보를 어지럽힐 수 있는 정보를 확산시키기 위한 목적으로, AI를 통해 만들어진 콘텐츠의 사용은 애초에 금지된다. 어떤 목적에서든 딥페이크를 이용해 만들어진 영상은 딥페이크 영상임을 명확하게 알려야 하고 원본을 추적할 수 있도록 워터마크도 넣어야 한다. 누군가의 얼굴이나 목소리를 합성하려면 당사자의 동의를 구해야 한다. 심지어 언론사에서 보도 목적으로 딥페이크 기술을 사용하려면 영상의 원본으로 정부가 승인한 매체만 활용할 수 있다. 사실상 딥페이크 기반의 정책 풍자나 비판을 막은 것이다.[21]

이처럼 법 제도적 대응은 딥페이크를 적용한 결과물이 저지르는 범법 행위에 대해 현행 법률을 적용하거나, 딥페이크를 겨냥해 특화 법률의 제정을 시도하는 방향으로 이뤄지고 있다. 첫 번째 방식과 관련해 제기되는 문제는 저작권이나 퍼블리시티권, 명예훼손법과 같은 현행 법률이 딥페이크가 야기하는 사회 문제를 과연 얼마나 해결할 수 있는가에 대한 의문이다. 사실 이 물음은 딥페이크가 등장하기 이전부터 디지털 저작물과 관련하여 끊임없이 제기되어 왔던 문제다. 디지털 저작물에 대한 권리와 이의 공정 이용(fair use), 개인의 명예 보호와 창작 자율성 사이의 해묵은 긴장 관계를 딥페이크의 사례에서도 다시금 확인하게 되는 것이다. 특히 디지털 저작물에 의한 피해에 대응하는 것은 미국의 수정헌법 제1조(First Amendment)로 대표되는, 표현의 자유의 가치와 충돌할 수 있다. 악의적 딥페이크를 범죄화하는 것은 정치적 패러디까지 자동으로 삭제, 제한하는 행위로 이어져 새로운 논란을 야기할 수 있으며, 이 점에서 법적 대응을 위해서는 사례별 접근과 판단이 중요한 변수로 작동하게 된다.

더 큰 문제는 판결 결과가 무엇이든, 판결이 내려지기 전에 이미 딥페이크 영상은 대량으로 널리 유통됐을 것이라는 사실이다. 특히 퍼블리시티권 등이 유명인사에게 주로 유리하게 작동하고, 일반인의 경우 적용하기까지 적지 않은 노력이 소요된다는 점에서 현행 법률이 딥페이크에 대한 실제적 대응력을 갖추기는 어려워 보인다. 딥페이크를 활용한 리벤지 포르노물이 유포되는 경우에도 피해자는 그 사실 자체를 아예 모를 가능성이 높으며, 안다 해도 처벌을 기대하기가 어려운 게 현실이다.

그렇다면, 미국의 의원들이 제출한 법안들이 그 대안이 될 수 있을까? ‘악의적 딥페이크 금지법’이나 DSA의 사례에서 보듯, 이 법안들은 여러 측면에서 기존의 가치와 충돌하거나 새로운 문제를 가져올 가능성이 있다. 특히 플랫폼과 같은 딥페이크 영상 배포자에게 책임을 부과하는 방식은 미국의 통신품위법(Communications Decency Act) 제230조와 같은, 인터넷에서의 표현의 자유를 신장시켜 온 법률과 배치된다.

통신품위법 230조는 인터넷 서비스 사업자(ISP·Internet service provider)가 자신이 중개한 표현에 대해 발행인으로서 책임을 질 필요 없이 완전 면책되도록 규정한 법이다. 인터넷 서비스 사업자가 온라인상의 표현에 법적 책임을 부담하게 될까 두려워 표현을 삭제하는 일이 없도록 한 것이다. 물론 이러한 면책 조항이 피해자의 명예보다는 표현의 자유 보호만을 중시해 인터넷 사업자가 유해한 표현을 차단할 동기를 없애 버리는 부작용이 있었던 것은 사실이다. 하지만 딥페이크를 대상으로 한 새로운 플랫폼 규제 법안은 표현의 자유를 침해하고 인터넷 사업자에 과도한 책임을 부과하는 부작용을 낳을 수 있다. 딥페이크에 의한 위협에 대응하기 위한 시도가 도리어 온라인 생태계에 의도치 않은 피해를 줄 수도 있다는 점을 간과할 수는 없는 노릇이다.

이처럼 딥페이크에 대한 법적 대응은 이미 존재하는 법률과 중복되거나, 다른 법률적 가치와 충돌하는 문제와 관련되기 쉽다. 딥페이크의 피해자를 보호하는 것은 표현의 자유를 침해할 수 있고, 표현의 자유를 보장하기 위해 딥페이크 피해자 보호의 수위를 낮추면 딥페이크의 위해성이 가늠할 수 없는 수준으로 커져 버리는 것이다.

이러한 긴장을 조정하는 것은 법원의 역할이지만, 실질적인 법적 구제 수단이 있더라도 딥페이크가 초래하는 위험에 충분히 대응하기 위해 새로운 논의 또한 진행돼야 한다는 사실만큼은 분명하다. 새로운 법률이 만들어진다 해도 이것이 사후적인 대응일 수밖에 없다는 점은 해결할 수 없는 한계이기 때문이다. 법적 유효성이 높다 해도 법은 피해가 일어난 다음에야 작동한다. 법률 바깥의 대응이 필요한 이유다.

기술 자체보다 기술이 야기하는 문제들에 관심을

딥페이크가 초래하는 위험에 대응하기 위해 산업적, 기술적, 법적으로 다양한 노력이 이루어지고 있지만, 딥페이크가 지니는 잠재적 위협이 모두 제거된 것은 아니다. 어떤 방법도 딥페이크가 불러 오는 문제에 대한 완전하고도 유일한 해결책이 될 수 없기에, 딥페이크 기술과 영향력에 대해 지속적으로 관심을 가지고 이해도를 높이는 것이 근본적인 대응 방안이라는 목소리가 점차 커지고 있다.

이와 관련하여 MIT 미디어 연구소와 하버드대학교 버크만 센터 ‘AI 윤리와 거버넌스 이니셔티브 (the Ethics and Governance of AI Initiative)’의 팀 황(Tim Hwang)은 실제 발생하는 구체적이고 개별적인 딥페이크 문제에 관심을 가지고 이에 대한 해결책을 마련하는 데 집중하는 것이 딥페이크 탐지 알고리즘을 개발하는 것보다 더 중요하다고 강조한다.[22] 자동화된 탐지 도구와 이의 산업적 적용, 가능한 문제들에 대한 법적 대응이 어디까지나 관련된 사람들의 폭넓은 이해와 관심 속에서 이뤄져야 한다는 뜻이다. 그는 기술과 인간 간 균형이 딥페이크에 대한 대응의 핵심이라고 봤다. 가령, 저널리스트나 리포터가 악의성 여부를 판단하기 어려운 애매한 경우나 딥페이크가 적용되는 특수한 맥락에 대한 사례를 제공해 줄 때 기술자와 연구자는 해당 기술의 원리와 활용을 보다 구체적으로 고민할 수 있을 것이다.

같은 맥락에서 전 사회적으로 딥페이크 기술과 딥페이크의 영향력에 대한 이해를 높이는 것이 딥페이크로 인한 부작용을 최소화하는 데 기여할 수 있다. 이와 관련해서는 노엘 마틴(Noelle Martin)이라는 한 여성의 사례에 주목해 볼 만하다. 마틴은 대학생이 된 후 소셜 미디어에 올린 자신의 이미지가 딥페이크 조작에 활용되어 포르노 DVD 표지로 만들어지고 포르노 사이트에 게시, 유통된 것을 알게 된다. 여기에는 심지어 마틴이 미성년자였을 때의 사진이 아동 포르노물과 합성된 경우도 있었다. 대다수의 피해자가 이러한 경우에 대해 쉬쉬하고 넘어간 것과 달리 노엘은 이에 공식적으로 대항하는 활동을 약 10년 간 지속해 오고 있다. 가해자의 신원을 모르는 상황에서 마틴은 가해자를 처벌하는 대신 법을 바꾸고자 결심했다. 마틴은 테드 강연(Ted Talk) 등을 통해 딥페이크로 인해 자신이 경험한 피해를 이야기하면서[23] 법령 제정의 필요성에 대해 역설했고, 이러한 활동은 호주에서 적대적 포르노에 대한 법률이 제정되는 데 영향을 미치는 등 실질적인 효과를 가져왔다. 포기를 거부한 그녀의 태도와 행동은 딥페이크와 그로 인한 여성 대상의 폭력과 위협의 이슈를 환기하고 피해자의 지위를 법적으로 회복하는 데 기여했다고 평가받는다.[24]

이처럼, 딥페이크가 초래하는 위협에 대응하기 위해서는 광범위한 문화적 변화가 필요하다. 특히, 피해자들의 침묵보다는 행동이, 사회적 무지보다는 관심이, 대중의 흥미보다는 인식의 향상이 중요하다. 딥페이크로 인해 영상이 조작될 수 있다는 사실, 조작된 영상 때문에 피해를 입은 사람이 어딘가에 존재할 수 있다는 사실, 이를 신고하면 삭제 등의 조치가 취해질 수 있다는 사실을 아는 사람이 많아질수록 딥페이크에 대한 사회적 대응책의 힘은 강해질 수 있다.

‘ASI 데이터 사이언스(ASI Data Science)’의 연구원 존 깁슨(John Gibson)은 2018년 열린 제15회 얄타 유럽 전략 회의(Yalta European Strategy)에서 영상과 음성 합성 기술의 가능성에 대한 사람들의 인식을 제고하는 것이 중요함을 역설한 바 있다. 그는 딥페이크를 ‘램프에서 빠져나온 지니’에 비유하면서, 영상 합성 기술이 앞으로 대중들에 의해 더 많이 이용될 것이고 이러한 발전을 정부가 통제할 수는 없을 것이라 전망했다. 깁슨은 정부의 통제 대신 허위정보의 영향을 완화하는 방향으로 해결책이 집중되는 것이 중요하며, 그중 하나는 사람들이 영상의 정치적 맥락을 인식하도록 돕는 것이라고 이야기했다.

다행인 것은 2018년이나 2022년 미국 대선, 러시아-우크라이나 전쟁 같은 대형 정치적, 군사적 사건이 진행되는 과정에서 딥페이크로 인한 심각한 수준의 허위정보 문제는 발생하지 않았다는 사실이다. 오히려 대통령의 얼굴을 합성한 영상은 딥페이크가 어떻게 정치적으로 활용될 수 있는지를 보여줌으로써 해당 기술에 대한 사회적 인식을 높이는 데 기여할 수 있었다. 이와 같은 효과가 앞으로도 지속될 것인가? 허위정보의 문제가 심화하는 상황에서 물음의 답을 쉽사리 내릴 수는 없을 것이다. 하지만 분명한 사실은 사회적 인식과 문화적 변화가 딥페이크를 멈추거나 사라지게 할 수는 없더라도 딥페이크의 부정적 영향력을 둔화시키는 데에는 반드시 도움이 되리라는 것이다.

지금까지 딥페이크로 인해 발생하는 문제점과 그에 대한 대응, 그리고 대응의 한계점들을 살펴봤다. 이러한 한계들을 극복하고 딥페이크가 사회적으로 수용되고 창작의 도구로 더욱 널리 활용될 수 있도록 우리가 해야 할 일은 무엇일까?

나로부터 시작하기

무엇보다 중요한 것은 온라인 이용자 개개인이 딥페이크 기술을 악용하지 않고, 딥페이크가 악의적으로 만들어 낸 영상에 휘둘리지 않는 자세를 기르는 것이다. 딥페이크의 파급력은 전문적인 지식이나 기술이 없어도 매우 쉽고 광범위하게 다수에 의해 현실을 조작할 수 있다는 것에서 나온다. 악의적 포르노나 명예훼손 등 딥페이크와 관련한 문제들은 생성적 적대 신경망이 얼마나 이미지를 잘 학습하고, 필요한 부분을 대체, 합성하는지가 아니라 어떤 이미지를 학습하여 어떤 이미지와 합성한 후 어떤 영상을 만들어 낼 것인가를 결정하는 인간의 판단과 의지에서 발생한다. 딥페이크로 인한 폭력과 사실의 위기는 딥페이크 기술 자체보다는 딥페이크 기술의 ‘이용’으로부터 초래되는 셈이다. 따라서 딥페이크 기술의 악용 가능성에 대해 인지하고, 이를 사회적으로 올바른 방향으로만 사용하려는 이용자 개개인의 노력이 가장 중요한 과제로 꼽힌다.

온라인에서 딥페이크 영상을 접하고 소비하는 사람들의 경험과 지식을 함양하는 것 또한 중요하다. 혁신적인 탐지 기술이 딥페이크 영상을 실시간으로 식별하더라도 사람들이 이를 믿고 마음을 바꾸지 않는다면 아무런 소용이 없을 것이다. 조작된 영상과 영상이 조작됐다고 이야기하는 탐지 알고리즘 중 무엇을 더 신뢰할 것인지, 또는 서로 다른 탐지 알고리즘이 영상의 진위 여부에 대해 상충하는 평결을 내릴 때 무엇을 믿어야 하는지의 문제는 딥페이크라는 기술과 별도로 발생하는 또 다른 선택의 문제다. 이 선택에 따라 사실(fact)이 다시 위기에 처할 수도 있다. 오바마 대통령이 인종 차별적인 사람이라 믿는 이들은 그가 영상에서 눈을 깜빡이든 그렇지 않든 인종 차별적인 연설을 내뱉는 장면을 사실로 받아들일 것이다. 인간의 마음과 인식, 동의와 믿음은 AI 알고리즘이나 딥페이크 기술보다 더 ‘디버깅’하기 어려운 대상이기에, 이 시스템이 어떻게 사실을 강화하는 방향으로 학습할 수 있을 것인지에 대한 고민이 다른 어떤 대응들 못지않게 필요하다.

딥페이크, 나아가 모든 유형의 허위정보에 대한 이용자의 이해와 정확한 판단 능력, 즉 리터러시(literacy)를 제고하는 노력은 이 문제의 가장 현실성 있는 대안이라 할 수 있다. 대학 등 학술 기관이 진행하는 미디어 리터러시 프로그램을 하나의 사례로 살펴볼 수 있다. 가령, 뉴욕의 티시예술대학교(NYU Tisch)는 ‘뉴스 위조하기(Faking the News)’라는 과목에서 학생들에게 AI 기술을 활용해 콘텐츠를 위조하는 방법을 가르침으로써 딥페이크의 위험성을 알린 바 있다. 학생들은 직접 위조 콘텐츠를 만들며 기술의 잠재성과 함의, 그리고 해당 기술의 한계 또한 배울 수 있었다.

션 등의 연구 [25]에 따르면 온라인상의 가짜 이미지에 대한 신뢰도 평가에는 출처의 유무보다 이용자의 인터넷 능력과 이미지 편집 경험, 미디어 이용 정도가 더 큰 영향을 미친다. 이용자의 미디어 리터러시가 높을 때 가짜 이미지를 판별하고 신뢰도를 조정할 가능성이 더 높다는 말이다. 딥페이크 기술 자체에 대한 지식을 전달하는 것을 넘어, 허위정보 전반에 대처하는 총체적이고 종합적인 역량으로서의 미디어 리터러시를 높이는 것이 중요하다. 탄탄해진 미디어 리터러시를 기반으로, 현실에 대한 평가와 가치 판단을 내리도록 하는 교육 과정이 무엇보다 중요할 것이다. 특히 Z세대의 경우 대부분의 활동을 온라인에서 진행하고, 동영상을 이용하는 경우가 많기 때문에 리터러시 교육을 통해 딥페이크로 인한 허위정보의 문제에 대응하려는 노력이 필요하다. 가령, 버즈피드 는 딥페이크 영상을 식별하는 다섯 가지 팁[26]을 정리하고 있는데,[27] 이러한 사실을 젊은 세대가 유념하는 것만으로도 딥페이크로 인한 위험을 줄일 수 있을 것이다.

블랙박스화를 넘어서

인터넷 플랫폼, 또는 서비스 사업자의 경우 딥페이크 탐지 기술을 개발하고 이를 플랫폼에 기본적으로 탑재하는 등의 역할이 사회적으로 요구될 가능성이 크다. 기존의 대응이 이용자의 신고와 요청을 받아들이는 소극적 수준에 머물렀다면, 앞으로는 정보의 유통과 확산에 대한 책무를 적극적으로 요구받는 것이다. 딥페이크를 탐지할 수 있는 자체 AI 모델을 플랫폼에 구축하거나 영상 콘텐츠를 출처나 업로드 일시, 진위 탐지 결과 등의 부가 정보와 함께 게시하는 정책을 적용하는 것 등이 향후 인터넷 사업자들이 취할 수 있는 방안으로 논의된다.

이때 중요한 것은 딥페이크에 대한 플랫폼의 대응 자체가 플랫폼의 핵심 내부자만 그 내용을 알 수 있는, 이른바 ‘블랙박스화‘될 가능성을 유념하는 것이다. 딥페이크 탐지 기술 또한 이용자, 엔지니어가 쉽게 이해하고 접근할 수 있는 형태로 제공돼야 한다. 딥페이크 탐지 기술의 블랙박스를, 전부는 아니더라도 가능한 수준에서 공개하는 것이 플랫폼에 적용할 수 있는 모델을 개발하는 것만큼 중요하다는 사실을 잊어서는 안 된다. 딥페이크 탐지 기술 개발의 이면에서 이뤄지는 의사 결정 과정을 투명하게 공개하는 것도 필요하다. 영상의 원본성에 대한 ‘인증’이 의미하는 바가 명확할 때에만 비로소 그 인증을 기반으로 한 신뢰가 구축될 수 있기 때문이다.

이 점에서 ‘리얼리티 디펜더(Reality Defender)’의 사례는 주목할 만하다. 리얼리티 디펜더는 미국의 ‘AI 재단(AI Foundation)’이 딥페이크로 인한 미국 대선 관련 정보 오염을 막기 위해 2020년에 출범한 딥페이크 탐지 기술 플랫폼이다. 독일의 뮌헨공과대학교의 페이스 포렌식 프로젝트를 기반으로 시작해 현재 수백 개 이상의 학교, 기업, 기관 등이 참여하는 대형 프로젝트로 성장했다. 기존에 알려진 딥페이크 탐지 모델 중 정확도가 높았던 모델들을 통합해 더욱 확장성 있는 탐지 모델을 제작하고, 이를 웹 앱 등으로 쉽게 활용할 수 있도록 한다. 미국 국토안보부, 미국 국방부, 육군, CIA등의 정부 기관, ABC, 《워싱턴포스트》, 《와이어드》, 프로퍼블리카 등의 언론, 링크드인, 페이스북과 같은 소셜 미디어 기업과도 제휴해 이들 조직이 데이터 진위를 판단할 수 있도록 지원하는 중이다. 리얼리티 디펜더는 여러 기관이 연합으로 정보를 공개, 공유하며 딥페이크 탐지 기술을 개발하고 기술의 적용 대상을 확대하려는 노력이라는 점에서 높이 평가할 만하다. 딥페이크 기술이 날로 발전하는 상황에서 단일 기업이나 기관이 단독으로 ‘만능’ 탐지 기술을 개발하는 것은 사실상 불가능하다. 리얼리티 디펜더처럼 딥페이크 탐지 기술을 적극적으로 공유, 개발하려는 시도가 앞으로 더욱 확대돼야 할 것이다.

믿을만한 중개인, 언론

딥페이크는 허위정보의 생성과 확산을 가속화한다. 사실의 지표로 간주되던 영상의 원본성이 의심받기 시작했다는 것은 대중이 온라인에서 만나는 미디어와 콘텐츠를 더 이상 신뢰할 수 없는 상황에 처했음을 뜻한다. 사실과 진실이 쉽게 오염될 수 있는 상황에서, 사회가 어떻게 정보를 수용하고 공유하도록 할 것인지의 과제가 떠오를 수밖에 없다.

컴퓨터공학 연구자이자 미디어 연구자인 니콜라스 디아코플로스(Nicholas Diakopoulos)는 《콜럼비아 저널리즘 리뷰(Columbia Journalism Review)》 에 실린 칼럼을 통해 바로 이 지점에서 오히려 주류 언론이 권위를 회복하고 사회에 기여하는 기회를 가질 수 있을 것이라 말한다.[28] 대중이 온라인 콘텐츠를 더 이상 신뢰할 수 없다는 것을 알게 되면 믿을만한 평가자 및 중개인을 필요로 하게 되는데, 이 역할을 언론이 수행할 수 있다는 것이다. 그는 이러한 기회를 포착하기 위해 언론과 언론인이 미디어 포렌식 교육과 기술 도구 개발, 프로세스 표준화 및 투명성과 같은 전략을 추구할 필요가 있다고 강조한다.

언론사는 포렌식 도구를 개발・통합하고, 영상의 진위 여부를 결정할 때 필요한 맥락 단서를 제공할 수 있다. 이미지 합성이 쉬워질수록 시간, 장소, 환경 등에 대한 메타 데이터가 적절한 검증을 위해 더욱 중요해지는데, 이러한 맥락을 해석하는 역할을 언론이 수행하는 것이다. 언론사 역시 플랫폼과 마찬가지로 콘텐츠의 평가 과정을 문서화하는 등 합성 영상의 검증을 위한 과정을 표준화하고 공개해야 한다. 사실과 진실이 오염되는 시대에 언론이 사실을 해석하고 이 과정을 공개한다면, 그 위상은 새로이 정립될 수 있다. 믿을 만한 콘텐츠의 유통 경로로서의 언론으로 재탄생하는 것이다.

규제가 능사는 아니다

다수의 전문가들은 온라인 이용자와 플랫폼, 언론에게 부과된 새로운 과제가 정부 주도로 진행되는 것을 경계한다. 딥페이크에 대한 법적 대응이 데이터 기반 비즈니스의 핵심인 데이터 공유와 혁신을 거부하는 방향, 특히 콘텐츠에 대한 직접 제재 방식으로 이루어지는 것을 피해야 한다는 이유 때문이다.

대신 정부는 이용자와 언론, 기관의 정보 리터러시를 높이는 교육을 실시하고, 공공-민간의 파트너십이나 핵심 관계자들 간의 협력을 증진하는 등, 사회적 신뢰를 높이는 방향으로 기능할 수 있을 것이다. 미국의 방위 고등 연구 계획국 ‘DARPA’의 미디어 포렌식 프로그램은 정부의 직접 개입 없이 연구를 지원하는 것만으로도 딥페이크 탐지 기술 발전에 기여할 수 있음을 보여 줬다. EU에서도 유사하게 인비드 프로젝트가 진행된 바 있다. 프랑스 통신사 AFP를 비롯하여 일곱 개국 소속 아홉 개 기관, 및 기업이 참여하고 있는 이 프로젝트는 EU가 2016년 1월부터 진행 중인 혁신 프로그램 ‘호라이즌 2020(Horizon 2020)’의 기금 지원을 기반으로 한다. 호라이즌 2020의 기금 규모는 약 800억 유로에 달한다. 인비드 프로젝트를 통해 페이스북이나 유튜브와 같은 소셜 미디어에서 유통되는 동영상의 진위 여부를 자동으로 파악하는 도구가 개발됐다. 또한 영상의 과거 사용 전력을 확인하고 영상에 삽입된 로고를 감지함으로써 영상의 이용자가 저작권자를 확인할 수 있게 해 주는 방안 역시 제시됐다. 이러한 성과는 정부 주도의 국가 간 협력 사업이 허위정보로 인해 발생하는 사회적 비용을 줄일 수 있음을 보여 준다.

아울러 정부는 딥페이크로 인한 허위정보에 어떻게 대처할 것인지, 사회적 신뢰를 어떻게 높일 것인지에 대한 중장기 로드맵을 구축할 필요가 있다. 일시적으로 발생하는 단발적 사건에 단기적 처방으로 대응하거나, 강한 법적인 규제 일변도로 나아가는 것은 표현의 자유를 침해하거나 새로운 플랫폼에서의 미디어의 활동 영역을 축소하는 등 부작용을 낳을 수 있다. 단계적으로 딥페이크로 인한 허위정보 생성 실태를 파악하고 이에 대한 이해 관련자의 의견을 종합적으로 수렴, 사회적 차원에서의 대응 방안을 마련할 수 있는 체계가 마련돼야 한다. 딥페이크와 관련된 허위정보 대응 체계에 정부의 전 부처가 참여하는 것, 딥페이크를 통한 허위정보 생성 및 유통과 관련된 연구 계획을 수립하고 꾸준히 실행하는 것도 정부가 해야 하는 중요한 역할이다.

폭력의 방지에서 창작의 증진으로

딥페이크에 대한 사회적 대응은 딥페이크로 인한 부정적 효과 및 부작용을 최소화하는 데 집중돼 있다. 그 방법 또한 사후적인 경우가 많다. 사전에 딥페이크의 악의적 활용을 예방하거나, 딥페이크를 이용한 창작을 활성화하는 방안을 마련하는 데까지는 아직 사회적 논의가 나아가지 못하는 실정이다.

새로운 기술과 서비스가 등장하면 사람들은 이에 대해 조금은 과도한 기대를 가진다. 가령, 트위터나 페이스북이 등장했을 때 사람들은 드디어 글로벌 차원에서 평등한 쌍방향 커뮤니케이션 채널이 마련됐다는 기대에 부풀었고, 앱스토어가 처음 마련됐을 때는 많은 사람들이 누구나 큰 자본 없이 디지털 콘텐츠 생태계의 제작자가 될 수 있다고 생각했다. 그러나 딥페이크의 경우, 대다수의 사람들이 기술의 가치보다는 부작용을 먼저 생각한다. 기술의 발전의 역사에서 이례적인 일이다. 딥페이크 기술이 존재감을 드러낸 첫 계기가 허위정보나 포르노그래피와 같은 부정적 사례였기 때문일 것이다. 기술을 제대로 바라보기 위해 우리는 딥페이크라는 기술이 만들어 내는 새로운 가치, 긍정적 사례에도 관심을 기울일 필요가 있다. 기술 개발자와 영상 이용자, 플랫폼, 언론, 정부 모두가 이 과정에 참여해야 할 것이다.

이러한 사례가 쌓일 때 우리는 비로소 딥페이크가 인간 존재에 대해 새롭게 던지는 질문들을 보다 심도 있게 논할 수 있다. 딥페이크는 영상에 ‘드러난 얼굴’ 뿐 아니라 이로 인해 ‘감춰진 얼굴’, 그리고 새롭게 주체로서 활동하려는 ‘가상의 얼굴’과 관련된 다양한 질문을 우리 사회에 던지고 있다. 산업적, 법적, 제도적 대응을 넘어, 보다 근본적인 문제들에 철학적, 윤리적, 도덕적으로 어떻게 대응할 것인가는 여전히 과제로 남아 있다. 딥페이크 기술 자체를 넘어 ‘딥페이크의 얼굴’을 사회적으로 수용하기 위해, 앞으로 우리는 더 많은 질문을 던져야 한다.

무엇을 해야 하나?

지금까지 딥페이크로 인해 발생하는 문제점과 그에 대한 대응, 그리고 대응의 한계점들을 살펴봤다. 이러한 한계들을 극복하고 딥페이크가 사회적으로 수용되고 창작의 도구로 더욱 널리 활용될 수 있도록 우리가 해야 할 일은 무엇일까?

나로부터 시작하기

무엇보다 중요한 것은 온라인 이용자 개개인이 딥페이크 기술을 악용하지 않고, 딥페이크가 악의적으로 만들어 낸 영상에 휘둘리지 않는 자세를 기르는 것이다. 딥페이크의 파급력은 전문적인 지식이나 기술이 없어도 매우 쉽고 광범위하게 다수에 의해 현실을 조작할 수 있다는 것에서 나온다. 악의적 포르노나 명예훼손 등 딥페이크와 관련한 문제들은 생성적 적대 신경망이 얼마나 이미지를 잘 학습하고, 필요한 부분을 대체, 합성하는지가 아니라 어떤 이미지를 학습하여 어떤 이미지와 합성한 후 어떤 영상을 만들어 낼 것인가를 결정하는 인간의 판단과 의지에서 발생한다. 딥페이크로 인한 폭력과 사실의 위기는 딥페이크 기술 자체보다는 딥페이크 기술의 ‘이용’으로부터 초래되는 셈이다. 따라서 딥페이크 기술의 악용 가능성에 대해 인지하고, 이를 사회적으로 올바른 방향으로만 사용하려는 이용자 개개인의 노력이 가장 중요한 과제로 꼽힌다.

온라인에서 딥페이크 영상을 접하고 소비하는 사람들의 경험과 지식을 함양하는 것 또한 중요하다. 혁신적인 탐지 기술이 딥페이크 영상을 실시간으로 식별하더라도 사람들이 이를 믿고 마음을 바꾸지 않는다면 아무런 소용이 없을 것이다. 조작된 영상과 영상이 조작됐다고 이야기하는 탐지 알고리즘 중 무엇을 더 신뢰할 것인지, 또는 서로 다른 탐지 알고리즘이 영상의 진위 여부에 대해 상충하는 평결을 내릴 때 무엇을 믿어야 하는지의 문제는 딥페이크라는 기술과 별도로 발생하는 또 다른 선택의 문제다. 이 선택에 따라 사실(fact)이 다시 위기에 처할 수도 있다. 오바마 대통령이 인종 차별적인 사람이라 믿는 이들은 그가 영상에서 눈을 깜빡이든 그렇지 않든 인종 차별적인 연설을 내뱉는 장면을 사실로 받아들일 것이다. 인간의 마음과 인식, 동의와 믿음은 AI 알고리즘이나 딥페이크 기술보다 더 ‘디버깅’하기 어려운 대상이기에, 이 시스템이 어떻게 사실을 강화하는 방향으로 학습할 수 있을 것인지에 대한 고민이 다른 어떤 대응들 못지않게 필요하다.

딥페이크, 나아가 모든 유형의 허위정보에 대한 이용자의 이해와 정확한 판단 능력, 즉 리터러시(literacy)를 제고하는 노력은 이 문제의 가장 현실성 있는 대안이라 할 수 있다. 대학 등 학술 기관이 진행하는 미디어 리터러시 프로그램을 하나의 사례로 살펴볼 수 있다. 가령, 뉴욕의 티시예술대학교(NYU Tisch)는 ‘뉴스 위조하기(Faking the News)’라는 과목에서 학생들에게 AI 기술을 활용해 콘텐츠를 위조하는 방법을 가르침으로써 딥페이크의 위험성을 알린 바 있다. 학생들은 직접 위조 콘텐츠를 만들며 기술의 잠재성과 함의, 그리고 해당 기술의 한계 또한 배울 수 있었다.

션 등의 연구 [25]에 따르면 온라인상의 가짜 이미지에 대한 신뢰도 평가에는 출처의 유무보다 이용자의 인터넷 능력과 이미지 편집 경험, 미디어 이용 정도가 더 큰 영향을 미친다. 이용자의 미디어 리터러시가 높을 때 가짜 이미지를 판별하고 신뢰도를 조정할 가능성이 더 높다는 말이다. 딥페이크 기술 자체에 대한 지식을 전달하는 것을 넘어, 허위정보 전반에 대처하는 총체적이고 종합적인 역량으로서의 미디어 리터러시를 높이는 것이 중요하다. 탄탄해진 미디어 리터러시를 기반으로, 현실에 대한 평가와 가치 판단을 내리도록 하는 교육 과정이 무엇보다 중요할 것이다. 특히 Z세대의 경우 대부분의 활동을 온라인에서 진행하고, 동영상을 이용하는 경우가 많기 때문에 리터러시 교육을 통해 딥페이크로 인한 허위정보의 문제에 대응하려는 노력이 필요하다. 가령, 버즈피드 는 딥페이크 영상을 식별하는 다섯 가지 팁[26]을 정리하고 있는데,[27] 이러한 사실을 젊은 세대가 유념하는 것만으로도 딥페이크로 인한 위험을 줄일 수 있을 것이다.

블랙박스화를 넘어서

인터넷 플랫폼, 또는 서비스 사업자의 경우 딥페이크 탐지 기술을 개발하고 이를 플랫폼에 기본적으로 탑재하는 등의 역할이 사회적으로 요구될 가능성이 크다. 기존의 대응이 이용자의 신고와 요청을 받아들이는 소극적 수준에 머물렀다면, 앞으로는 정보의 유통과 확산에 대한 책무를 적극적으로 요구받는 것이다. 딥페이크를 탐지할 수 있는 자체 AI 모델을 플랫폼에 구축하거나 영상 콘텐츠를 출처나 업로드 일시, 진위 탐지 결과 등의 부가 정보와 함께 게시하는 정책을 적용하는 것 등이 향후 인터넷 사업자들이 취할 수 있는 방안으로 논의된다.

이때 중요한 것은 딥페이크에 대한 플랫폼의 대응 자체가 플랫폼의 핵심 내부자만 그 내용을 알 수 있는, 이른바 ‘블랙박스화‘될 가능성을 유념하는 것이다. 딥페이크 탐지 기술 또한 이용자, 엔지니어가 쉽게 이해하고 접근할 수 있는 형태로 제공돼야 한다. 딥페이크 탐지 기술의 블랙박스를, 전부는 아니더라도 가능한 수준에서 공개하는 것이 플랫폼에 적용할 수 있는 모델을 개발하는 것만큼 중요하다는 사실을 잊어서는 안 된다. 딥페이크 탐지 기술 개발의 이면에서 이뤄지는 의사 결정 과정을 투명하게 공개하는 것도 필요하다. 영상의 원본성에 대한 ‘인증’이 의미하는 바가 명확할 때에만 비로소 그 인증을 기반으로 한 신뢰가 구축될 수 있기 때문이다.

이 점에서 ‘리얼리티 디펜더(Reality Defender)’의 사례는 주목할 만하다. 리얼리티 디펜더는 미국의 ‘AI 재단(AI Foundation)’이 딥페이크로 인한 미국 대선 관련 정보 오염을 막기 위해 2020년에 출범한 딥페이크 탐지 기술 플랫폼이다. 독일의 뮌헨공과대학교의 페이스 포렌식 프로젝트를 기반으로 시작해 현재 수백 개 이상의 학교, 기업, 기관 등이 참여하는 대형 프로젝트로 성장했다. 기존에 알려진 딥페이크 탐지 모델 중 정확도가 높았던 모델들을 통합해 더욱 확장성 있는 탐지 모델을 제작하고, 이를 웹 앱 등으로 쉽게 활용할 수 있도록 한다. 미국 국토안보부, 미국 국방부, 육군, CIA등의 정부 기관, ABC, 《워싱턴포스트》, 《와이어드》, 프로퍼블리카 등의 언론, 링크드인, 페이스북과 같은 소셜 미디어 기업과도 제휴해 이들 조직이 데이터 진위를 판단할 수 있도록 지원하는 중이다. 리얼리티 디펜더는 여러 기관이 연합으로 정보를 공개, 공유하며 딥페이크 탐지 기술을 개발하고 기술의 적용 대상을 확대하려는 노력이라는 점에서 높이 평가할 만하다. 딥페이크 기술이 날로 발전하는 상황에서 단일 기업이나 기관이 단독으로 ‘만능’ 탐지 기술을 개발하는 것은 사실상 불가능하다. 리얼리티 디펜더처럼 딥페이크 탐지 기술을 적극적으로 공유, 개발하려는 시도가 앞으로 더욱 확대돼야 할 것이다.

믿을만한 중개인, 언론

딥페이크는 허위정보의 생성과 확산을 가속화한다. 사실의 지표로 간주되던 영상의 원본성이 의심받기 시작했다는 것은 대중이 온라인에서 만나는 미디어와 콘텐츠를 더 이상 신뢰할 수 없는 상황에 처했음을 뜻한다. 사실과 진실이 쉽게 오염될 수 있는 상황에서, 사회가 어떻게 정보를 수용하고 공유하도록 할 것인지의 과제가 떠오를 수밖에 없다.

컴퓨터공학 연구자이자 미디어 연구자인 니콜라스 디아코플로스(Nicholas Diakopoulos)는 《콜럼비아 저널리즘 리뷰(Columbia Journalism Review)》 에 실린 칼럼을 통해 바로 이 지점에서 오히려 주류 언론이 권위를 회복하고 사회에 기여하는 기회를 가질 수 있을 것이라 말한다.[28] 대중이 온라인 콘텐츠를 더 이상 신뢰할 수 없다는 것을 알게 되면 믿을만한 평가자 및 중개인을 필요로 하게 되는데, 이 역할을 언론이 수행할 수 있다는 것이다. 그는 이러한 기회를 포착하기 위해 언론과 언론인이 미디어 포렌식 교육과 기술 도구 개발, 프로세스 표준화 및 투명성과 같은 전략을 추구할 필요가 있다고 강조한다.

언론사는 포렌식 도구를 개발・통합하고, 영상의 진위 여부를 결정할 때 필요한 맥락 단서를 제공할 수 있다. 이미지 합성이 쉬워질수록 시간, 장소, 환경 등에 대한 메타 데이터가 적절한 검증을 위해 더욱 중요해지는데, 이러한 맥락을 해석하는 역할을 언론이 수행하는 것이다. 언론사 역시 플랫폼과 마찬가지로 콘텐츠의 평가 과정을 문서화하는 등 합성 영상의 검증을 위한 과정을 표준화하고 공개해야 한다. 사실과 진실이 오염되는 시대에 언론이 사실을 해석하고 이 과정을 공개한다면, 그 위상은 새로이 정립될 수 있다. 믿을 만한 콘텐츠의 유통 경로로서의 언론으로 재탄생하는 것이다.

규제가 능사는 아니다

다수의 전문가들은 온라인 이용자와 플랫폼, 언론에게 부과된 새로운 과제가 정부 주도로 진행되는 것을 경계한다. 딥페이크에 대한 법적 대응이 데이터 기반 비즈니스의 핵심인 데이터 공유와 혁신을 거부하는 방향, 특히 콘텐츠에 대한 직접 제재 방식으로 이루어지는 것을 피해야 한다는 이유 때문이다.

대신 정부는 이용자와 언론, 기관의 정보 리터러시를 높이는 교육을 실시하고, 공공-민간의 파트너십이나 핵심 관계자들 간의 협력을 증진하는 등, 사회적 신뢰를 높이는 방향으로 기능할 수 있을 것이다. 미국의 방위 고등 연구 계획국 ‘DARPA’의 미디어 포렌식 프로그램은 정부의 직접 개입 없이 연구를 지원하는 것만으로도 딥페이크 탐지 기술 발전에 기여할 수 있음을 보여 줬다. EU에서도 유사하게 인비드 프로젝트가 진행된 바 있다. 프랑스 통신사 AFP를 비롯하여 일곱 개국 소속 아홉 개 기관, 및 기업이 참여하고 있는 이 프로젝트는 EU가 2016년 1월부터 진행 중인 혁신 프로그램 ‘호라이즌 2020(Horizon 2020)’의 기금 지원을 기반으로 한다. 호라이즌 2020의 기금 규모는 약 800억 유로에 달한다. 인비드 프로젝트를 통해 페이스북이나 유튜브와 같은 소셜 미디어에서 유통되는 동영상의 진위 여부를 자동으로 파악하는 도구가 개발됐다. 또한 영상의 과거 사용 전력을 확인하고 영상에 삽입된 로고를 감지함으로써 영상의 이용자가 저작권자를 확인할 수 있게 해 주는 방안 역시 제시됐다. 이러한 성과는 정부 주도의 국가 간 협력 사업이 허위정보로 인해 발생하는 사회적 비용을 줄일 수 있음을 보여 준다.

아울러 정부는 딥페이크로 인한 허위정보에 어떻게 대처할 것인지, 사회적 신뢰를 어떻게 높일 것인지에 대한 중장기 로드맵을 구축할 필요가 있다. 일시적으로 발생하는 단발적 사건에 단기적 처방으로 대응하거나, 강한 법적인 규제 일변도로 나아가는 것은 표현의 자유를 침해하거나 새로운 플랫폼에서의 미디어의 활동 영역을 축소하는 등 부작용을 낳을 수 있다. 단계적으로 딥페이크로 인한 허위정보 생성 실태를 파악하고 이에 대한 이해 관련자의 의견을 종합적으로 수렴, 사회적 차원에서의 대응 방안을 마련할 수 있는 체계가 마련돼야 한다. 딥페이크와 관련된 허위정보 대응 체계에 정부의 전 부처가 참여하는 것, 딥페이크를 통한 허위정보 생성 및 유통과 관련된 연구 계획을 수립하고 꾸준히 실행하는 것도 정부가 해야 하는 중요한 역할이다.

폭력의 방지에서 창작의 증진으로

딥페이크에 대한 사회적 대응은 딥페이크로 인한 부정적 효과 및 부작용을 최소화하는 데 집중돼 있다. 그 방법 또한 사후적인 경우가 많다. 사전에 딥페이크의 악의적 활용을 예방하거나, 딥페이크를 이용한 창작을 활성화하는 방안을 마련하는 데까지는 아직 사회적 논의가 나아가지 못하는 실정이다.

새로운 기술과 서비스가 등장하면 사람들은 이에 대해 조금은 과도한 기대를 가진다. 가령, 트위터나 페이스북이 등장했을 때 사람들은 드디어 글로벌 차원에서 평등한 쌍방향 커뮤니케이션 채널이 마련됐다는 기대에 부풀었고, 앱스토어가 처음 마련됐을 때는 많은 사람들이 누구나 큰 자본 없이 디지털 콘텐츠 생태계의 제작자가 될 수 있다고 생각했다. 그러나 딥페이크의 경우, 대다수의 사람들이 기술의 가치보다는 부작용을 먼저 생각한다. 기술의 발전의 역사에서 이례적인 일이다. 딥페이크 기술이 존재감을 드러낸 첫 계기가 허위정보나 포르노그래피와 같은 부정적 사례였기 때문일 것이다. 기술을 제대로 바라보기 위해 우리는 딥페이크라는 기술이 만들어 내는 새로운 가치, 긍정적 사례에도 관심을 기울일 필요가 있다. 기술 개발자와 영상 이용자, 플랫폼, 언론, 정부 모두가 이 과정에 참여해야 할 것이다.

이러한 사례가 쌓일 때 우리는 비로소 딥페이크가 인간 존재에 대해 새롭게 던지는 질문들을 보다 심도 있게 논할 수 있다. 딥페이크는 영상에 ‘드러난 얼굴’ 뿐 아니라 이로 인해 ‘감춰진 얼굴’, 그리고 새롭게 주체로서 활동하려는 ‘가상의 얼굴’과 관련된 다양한 질문을 우리 사회에 던지고 있다. 산업적, 법적, 제도적 대응을 넘어, 보다 근본적인 문제들에 철학적, 윤리적, 도덕적으로 어떻게 대응할 것인가는 여전히 과제로 남아 있다. 딥페이크 기술 자체를 넘어 ‘딥페이크의 얼굴’을 사회적으로 수용하기 위해, 앞으로 우리는 더 많은 질문을 던져야 한다.

[1]

Samantha Cole, 〈AI-Assisted Fake Porn Is Here and We’re All Fucked〉, Vice, 2017. 12. 12.

[2]

Jeremy Hsu, 〈Can AI Detect Deepfakes To Help Ensure Integrity of U.S. 2020 Elections?〉, 《IEEE Spectrum》, 2019.

[3]

Minki Hong, 〈Which One Is Real? Generating and Detecting Deepfakes〉, Samsung SDS Insights, 2022. 4. 28.

[4]

Yuezun Li, Ming-Ching Chang and Siwei Lyu, 〈In ictu oculi: Exposing ai generated fake face videos by detecting eye blinking〉, 2018 IEEE International Workshop on Information Forensics and Security, 2018.

[5]

Umur Aybars Ciftci, İlke Demir and Lijun Yin. 〈How Do the Hearts of Deep Fakes Beat? Deep Fake Source Detection via Interpreting Residuals with Biological Signals〉, 2020 IEEE International Joint Conference on Biometrics, 2020.

[6]

Tero Karras et al., 〈Analyzing and Improving the Image Quality of StyleGAN〉, Computer Vision and Pattern Recognition, 2020.

[7]

Li, Yuezun and Siwei Lyu, 〈Exposing DeepFake Videos By Detecting Face Warping Artifacts〉, Computer Vision and Pattern Recognition, 2018.

[8]

Ricard Durall et al., 〈Unmasking DeepFakes with simple Features〉, Machine Learning, 2020.

[9]

https://www.kaggle.com/c/deepfake-detection-challenge/leaderboard

[10]

Anil Ganti, 〈AI on AI Action: Gfycat Uses AI to Fight Deepfakes’ Morphed Celebrity Porn Videos〉, Wccftech, 2018. 2. 16.

Louise Matsakis, 〈Artificial Intelligence is now fighting fake porn〉, 《Wired》, 2018. 2. 14.

Louise Matsakis, 〈Artificial Intelligence is now fighting fake porn〉, 《Wired》, 2018. 2. 14.

[11]

Shannon Liao, 〈Gfycat says it’ll use machine learning to make more high-res GIFs〉, The Verge, 2017. 12. 14.

[12]

Jeremy Hsu, 〈Can AI Detect Deepfakes To Help Ensure Integrity of U.S. 2020 Elections?〉, 《IEEE Spectrum》, 2019.

[13]

https://truepic.com/

[14]

https://www.serelay.com/

[15]

Samantha Cole, 〈Gfycat’s AI Solution for Fighting Deepfakes Isn’t Working〉, Vice, 2018. 6. 19.

[16]

Pablo Tseng, 〈What Can The Law Do About ‘Deepfake’〉, McMillan, 2018.

Lorna Caddy, 〈Deepfakes: all is not what it seems〉, Inforrm’s Blog, 2018. 12. 19.

Lorna Caddy, 〈Deepfakes: all is not what it seems〉, Inforrm’s Blog, 2018. 12. 19.

[17]

법안 전문은 다음 링크에서 확인할 수 있다.

https://www.congress.gov/bill/115th-congress/senate-bill/3805/text

https://www.congress.gov/bill/115th-congress/senate-bill/3805/text

[18]

Kaveh Waddell, 〈Lawmakers plunge into ‘deepfake’ war〉, Axios, 2019. 1. 31.

[19]

John Villasenor, 〈Artificial Intelligecne, deepfakes, and the uncertain future of truth〉, Brookings, 2019. 2. 14.

Kaveh Waddell, 〈Lawmakers plunge into ‘deepfake’ war〉, Axios, 2019. 1. 31.

Kaveh Waddell, 〈Lawmakers plunge into ‘deepfake’ war〉, Axios, 2019. 1. 31.

[20]

물론, DSA에 규정된 의무들이 얼마나 잘 준수되도록 강제될 수 있을지는 다른 문제다. EU는 과거부터 규제만 무섭게 만들고 정작 집행은 하지 못하는 ‘종이호랑이’라는 평가를 받아왔다.

[21]

이청아, 〈中, 오늘부터 딥페이크 기술 세계 첫 규제〉, 《동아일보》, 2023. 1. 10.

[22]

Jeremy Hsu, 〈Can AI Detect Deepfakes To Help Ensure Integrity of U.S. 2020 Elections?〉, 《IEEE Spectrum》, 2019.

[23]

TEDx Talks, 〈Sexual predators edited my photos into porn - how I fought back | Noelle Martin〉, 2018. 3. 7.

[24]

Cara Curtis, 〈Deepfakes are being weaponized to silence women — but this woman is fighting back〉, The Next Web, 2018. 10. 5.

[25]

Cuihua Shen et al., 〈Fake images: The effects of source, intermediary, and digital media literacy on contextual assessment of image credibility online〉, 《New Media & Society》, 21(2), 2019. pp.438-463.

[26]

구체적으로 다음의 다섯 가지 내용을 포함한다; 바로 결론으로 넘어가지 마라(Don’t jump to conclusions), 출처를 살펴라(Consider the source), 온라인 공간 다른 곳에 이 영상이 있는지 확인하라(Check where else it is (and isn’t) online), 입 모양을 유심히 봐라(Inspect the mouth), 천천히 돌려 봐라(Slow it down).

[27]

Craig Silverman, 〈How To Spot A Deepfake Like The Barack Obama–Jordan Peele Video〉, BuzzFeed, 2018. 4. 18.

[28]

Nicholas Diakopoulos, 〈Reporting in a Machine Reality: Deepfakes, misinformation, and what journalists can do about them〉, 《Columbia Journalism Review》, 2018. 5. 15.