추천 콘텐츠

인공지능을 활용한 예술 작품은 현대 미술 영역의 일부로 자리 잡고 있다. 인공지능의 예술 작품을 생생하게 체감할 수 있는 최신 작품을 소개한다.

2019년 2월 9일, 미디어 아티스트이자 전자 음악가인 언해피 서킷(Unhappy Circuit)의 〈i_Remember〉[1] 공연이 서울에서 있었다. 넓은 공연장에는 책상과 의자, 노트북뿐이었다. 공연이 시작되고 20분 동안 관객이 확인할 수 있는 것은 두 가지다. 작가가 실시간으로 합성해 들려주는 노이즈 사운드와 정체를 알 수 없지만 아름답게 반짝이는 이미지. 이 두 가지 자극에 압도된 관객은 그것들이 어떤 의미를 담고 있는지 이해하려 애쓰게 된다. 관객의 뇌는 사운드와 이미지를 해석하기 위한 단서를 찾으려 한다. 그저 알 수 없는 색들의 향연인 줄만 알았던 이미지는 시간이 흐르면서 점차 사람의 형태를 갖춰 간다. 의미 없는 사운드 가운데 반복되는 소리가 있다는 것도 알아챌 수 있다.

기억의 확장

2019년 2월 9일, 미디어 아티스트이자 전자 음악가인 언해피 서킷(Unhappy Circuit)의 〈i_Remember〉[1] 공연이 서울에서 있었다. 넓은 공연장에는 책상과 의자, 노트북뿐이었다. 공연이 시작되고 20분 동안 관객이 확인할 수 있는 것은 두 가지다. 작가가 실시간으로 합성해 들려주는 노이즈 사운드와 정체를 알 수 없지만 아름답게 반짝이는 이미지. 이 두 가지 자극에 압도된 관객은 그것들이 어떤 의미를 담고 있는지 이해하려 애쓰게 된다. 관객의 뇌는 사운드와 이미지를 해석하기 위한 단서를 찾으려 한다. 그저 알 수 없는 색들의 향연인 줄만 알았던 이미지는 시간이 흐르면서 점차 사람의 형태를 갖춰 간다. 의미 없는 사운드 가운데 반복되는 소리가 있다는 것도 알아챌 수 있다.

작품의 정체는 마지막에 드러난다. 영상에 한 여자가 등장해 어릴 때 우연히 듣고 외운 닐 리드(Neil Reid)의 곡 〈마더 오브 마인(Mother of Mine)〉을 부르며, 돌아가신 어머니에 대한 기억을 떠올린다. 여자가 얼버무리며 노래를 중단하는 것으로 영상은 끝난다. 노래를 부른 여자는 작가의 어머니다. 〈i_Remember〉는 “나의 기억을 학습한 인공지능이 과연 내가 될 수 있는가?”라는 질문에서 출발했다. 20분간 관객이 듣고 본 것은 마지막에 등장한 영상을 원본 데이터로 삼아 인공지능이 학습한 결과물이다. 인공지능은 원본의 특징을 학습해 4000장의 새로운 이미지와 사운드를 만들어 냈다. 관객이 본 것은 영상 속 여자의 기억에 대한 인공지능의 기억이다.

기억한다는 건 그 자체로 내가 나일 수 있는 이유다. 하지만 인간은 자기 자신의 바깥에도 기억을 저장해 왔다. 역사상 등장한 거의 모든 기술 매체는 기억을 외부에 저장하고 드러내는 외재화(externalization) 작업을 수행한다. 동굴 벽화, 붓과 종이, 사진술, 영상, 컴퓨터 메모리가 대표적인 예다. 지금까지의 외재화는 한 가지 범위에만 국한됐다. 사진은 한순간의 기억을 외재화한 것이다. 영상도 기억 전체를 기록하고 표현할 수는 없다. 인공지능은 단순 저장을 넘어 새로운 기억을 재구성한다. 그렇다면 인공지능은 기억의 주체인가? 스스로의 기억을 만드는 인공지능과 나를 어떻게 구분할 수 있을까? 〈i_Remember〉는 기억이라는 개념 자체를 인간의 외부로 확장해야 할 시기가 왔음을 시사한다.

두 사람이 대화를 나누고 있다. 안부를 묻는 것부터 시작해 꽤 심오한 이야기가 오간다. 그런데 자세히 들어보니 대화가 매끄럽지 않다. 한쪽이 갑자기 화를 내거나, 맥락에 전혀 맞지 않는 말을 한다. 이상한 대화는 약 7분간 계속된다. 두 사람은 배우다. 이들은 인공지능 챗봇이 서로 대화하며 만들어 낸 문장을 그대로 읽으며 행동, 표정, 말투 같은 비언어적인 부분만 연기했다. 챗봇은 온라인 소셜 커뮤니티에서 올라온 대화를 데이터베이스로 문장을 만들었다. 사람들이 온라인상에 남긴 수만 개의 대화는 인공지능의 말이 되고, 이 대화를 다시 인간이 읽는다. 인간과 인공지능의 말은 서로 섞여 어느 누구의 것이 아닌 혼성의 무언가가 된다. 박관우의 작품 〈휴먼 컨버세이션(Human Conversation) 1〉은 이렇게 구성되어 있다.[2]

최근 인공지능 스피커는 그 종류가 다양해지고 가격 진입 장벽도 낮아져 많은 가정에 보급되었다. 이에 따라 나타난 현상이 있다. 인공지능 스피커 유저들의 언어 습관이 변한 것이다. 또박또박, 최대한 단순한 명령어로 이야기해야 더 잘 인식하는 인공지능 스피커에 적응해 사람과 대화할 때도 같은 방식으로 말을 하는 것이다. 이 현상은 특히 말을 배우는 아이들에게 더 두드러지게 나타나는데, 태어나서 처음 한 말이 알렉사(Alexa, 아마존 인공지능의 이름)인 경우도 있다고 한다.

물론 이러한 현상은 인공지능이 성인 인간의 평균 어휘력이나 문장력을 따라갈 수 없기 때문이다. 짧으면 몇 년 안에 해결될 수 있는 문제다. 하지만 기계가 완벽하게 인간처럼 말하게 될 것이라는 생각 자체에 의문을 던져 보자. 변하는 건 기계만이 아닐 수도 있다. 인간도 변한다. 인간처럼 말하는 인공지능, 그리고 인공지능의 대화를 다시 읽으면서 인공지능의 언어를 습득하는 인간. 반복되다 보면 대화라는 행위의 지표가 인간에게서 멀어질지도 모른다. 박관우의 작품은 이러한 경계의 변화를 보여 준다. 언젠가는 경계 자체가 무의미해지는 날도 오겠지만, 분명 변화는 인간과 인공지능 양쪽에서 일어나고 있다.

캡차(CAPTCHA·Completely Automated Public Turing test to tell Computers and Humans Apart)는 인간과 컴퓨터를 구분하는 기술이다. 웹 사이트에 가입할 때, 본인 인증을 위해 컴퓨터는 인식하지 못하는 일그러진 이미지 속 숫자를 입력하거나 아홉 장의 사진 중에서 특정 물체가 있는 사진을 찾아 클릭하는 것, 친구 이름과 프로필 사진을 매칭하는 것이 모두 캡차 기술이다.

그러나 이제는 컴퓨터가 인간보다 더 잘 보고, 더 잘 골라내기 시작했다.[3] 컴퓨터를 속이기 위해 개발된 어렵고 복잡한 캡차를 내가 통과하지 못할 수도 있다. 그때의 나를, 인간이라고 칭할 수 있을까? 인간만이 인식할 수 있는 것은 과연 무엇일까? 컴퓨터 공학을 전공한 신승백과 시각 예술을 전공한 김용훈이 2012년 결성한 미디어 아티스트 듀오는 이 질문에 대한 답을, 다시 말해 인간과 기계의 인식 차이를 드러내는 작업 〈넌페이셜 포트레이트(Nonfacial Portrait)〉[4]를 선보였다.

기억한다는 건 그 자체로 내가 나일 수 있는 이유다. 하지만 인간은 자기 자신의 바깥에도 기억을 저장해 왔다. 역사상 등장한 거의 모든 기술 매체는 기억을 외부에 저장하고 드러내는 외재화(externalization) 작업을 수행한다. 동굴 벽화, 붓과 종이, 사진술, 영상, 컴퓨터 메모리가 대표적인 예다. 지금까지의 외재화는 한 가지 범위에만 국한됐다. 사진은 한순간의 기억을 외재화한 것이다. 영상도 기억 전체를 기록하고 표현할 수는 없다. 인공지능은 단순 저장을 넘어 새로운 기억을 재구성한다. 그렇다면 인공지능은 기억의 주체인가? 스스로의 기억을 만드는 인공지능과 나를 어떻게 구분할 수 있을까? 〈i_Remember〉는 기억이라는 개념 자체를 인간의 외부로 확장해야 할 시기가 왔음을 시사한다.

바뀌는 건 기계만이 아니다

두 사람이 대화를 나누고 있다. 안부를 묻는 것부터 시작해 꽤 심오한 이야기가 오간다. 그런데 자세히 들어보니 대화가 매끄럽지 않다. 한쪽이 갑자기 화를 내거나, 맥락에 전혀 맞지 않는 말을 한다. 이상한 대화는 약 7분간 계속된다. 두 사람은 배우다. 이들은 인공지능 챗봇이 서로 대화하며 만들어 낸 문장을 그대로 읽으며 행동, 표정, 말투 같은 비언어적인 부분만 연기했다. 챗봇은 온라인 소셜 커뮤니티에서 올라온 대화를 데이터베이스로 문장을 만들었다. 사람들이 온라인상에 남긴 수만 개의 대화는 인공지능의 말이 되고, 이 대화를 다시 인간이 읽는다. 인간과 인공지능의 말은 서로 섞여 어느 누구의 것이 아닌 혼성의 무언가가 된다. 박관우의 작품 〈휴먼 컨버세이션(Human Conversation) 1〉은 이렇게 구성되어 있다.[2]

최근 인공지능 스피커는 그 종류가 다양해지고 가격 진입 장벽도 낮아져 많은 가정에 보급되었다. 이에 따라 나타난 현상이 있다. 인공지능 스피커 유저들의 언어 습관이 변한 것이다. 또박또박, 최대한 단순한 명령어로 이야기해야 더 잘 인식하는 인공지능 스피커에 적응해 사람과 대화할 때도 같은 방식으로 말을 하는 것이다. 이 현상은 특히 말을 배우는 아이들에게 더 두드러지게 나타나는데, 태어나서 처음 한 말이 알렉사(Alexa, 아마존 인공지능의 이름)인 경우도 있다고 한다.

물론 이러한 현상은 인공지능이 성인 인간의 평균 어휘력이나 문장력을 따라갈 수 없기 때문이다. 짧으면 몇 년 안에 해결될 수 있는 문제다. 하지만 기계가 완벽하게 인간처럼 말하게 될 것이라는 생각 자체에 의문을 던져 보자. 변하는 건 기계만이 아닐 수도 있다. 인간도 변한다. 인간처럼 말하는 인공지능, 그리고 인공지능의 대화를 다시 읽으면서 인공지능의 언어를 습득하는 인간. 반복되다 보면 대화라는 행위의 지표가 인간에게서 멀어질지도 모른다. 박관우의 작품은 이러한 경계의 변화를 보여 준다. 언젠가는 경계 자체가 무의미해지는 날도 오겠지만, 분명 변화는 인간과 인공지능 양쪽에서 일어나고 있다.

인간을 정의하는 방법

캡차(CAPTCHA·Completely Automated Public Turing test to tell Computers and Humans Apart)는 인간과 컴퓨터를 구분하는 기술이다. 웹 사이트에 가입할 때, 본인 인증을 위해 컴퓨터는 인식하지 못하는 일그러진 이미지 속 숫자를 입력하거나 아홉 장의 사진 중에서 특정 물체가 있는 사진을 찾아 클릭하는 것, 친구 이름과 프로필 사진을 매칭하는 것이 모두 캡차 기술이다.

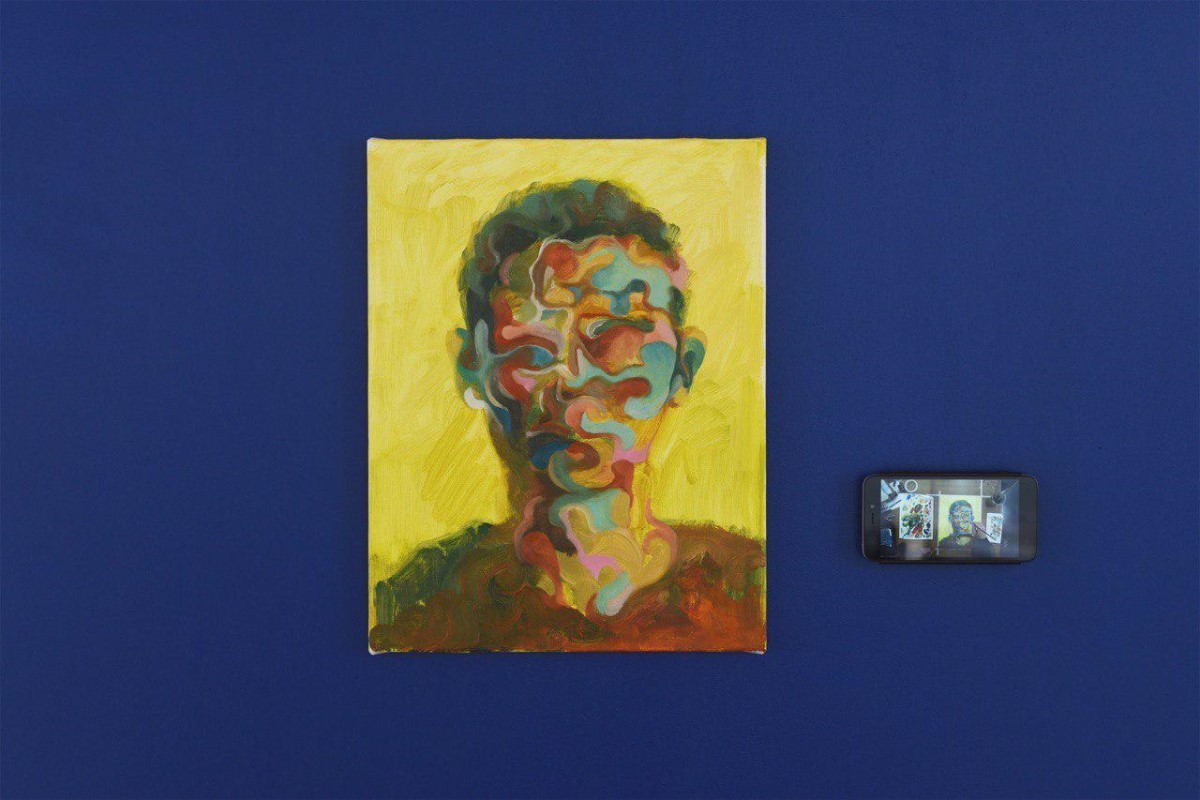

그러나 이제는 컴퓨터가 인간보다 더 잘 보고, 더 잘 골라내기 시작했다.[3] 컴퓨터를 속이기 위해 개발된 어렵고 복잡한 캡차를 내가 통과하지 못할 수도 있다. 그때의 나를, 인간이라고 칭할 수 있을까? 인간만이 인식할 수 있는 것은 과연 무엇일까? 컴퓨터 공학을 전공한 신승백과 시각 예술을 전공한 김용훈이 2012년 결성한 미디어 아티스트 듀오는 이 질문에 대한 답을, 다시 말해 인간과 기계의 인식 차이를 드러내는 작업 〈넌페이셜 포트레이트(Nonfacial Portrait)〉[4]를 선보였다.

〈넌페이셜 포트레이트〉는 각기 다른 작가가 그린 아홉 개의 초상화로 이뤄진 작품이다. 신승백과 김용훈은 작가들에게 초상화를 요청하며 한 가지 규칙을 부여했다. 컴퓨터가 알아보지 못하게 얼굴을 그릴 것. 인공지능 알고리즘은 캔버스를 향해 설치된 카메라를 통해 초상화가 그려지는 과정을 지켜본다. 초상화가 얼굴과 너무 비슷하면 인공지능이 얼굴을 인식해 규칙에 어긋난다. 그렇다고 너무 추상적으로 그리면 초상화라고 할 수가 없다. 아홉 명의 작가는 눈과 코, 입의 위치를 바꾸거나, 그림을 최대한 흐리게 만들고, 완성된 그림 위에 물감을 덮어 버리는 등 다양한 방식으로 초상화를 그렸다. 그 결과, 인간은 알아볼 수 있지만, 기계는 알아보지 못하는 그림, 하나의 캡차가 완성됐다.

각 초상화의 작업 과정을 담은 영상을 보면, 인공지능과 인간이 서로의 인식 영역을 걸고 게임을 하는 것 같다. 인공지능 알고리즘은 빠르고 정확하게 얼굴을 찾아내고, 작가는 이에 질세라 계속해서 색다른 얼굴을 만든다. 서로 대척점에 서 있는 것처럼 보이지만, 오히려 인공지능은 인간을 드러내는 미디어로 작동한다. 영화를 24프레임으로 촬영하는 이유는 프레임 전환의 속도를 눈의 깜빡임이 따라잡을 수 없도록 하기 위해서다. 텔레비전의 망점(網點)과 관련해서는 망막의 한계를 이야기할 수밖에 없다. 이처럼 기술적 미디어는 인간의 감각을 능가함으로써 인간을 정의한다. 〈넌페이셜 포트레이트〉에서 인공지능은 인간만의 인식 영역을 찾아냄과 동시에 인간 인식의 한계 역시 드러낸다. 그렇게 우리는 인공지능에 의해 정의된다.

독일 뮌헨을 거점으로 활동하는 작가 마리오 클링게만(Mario klingemann)은 창작하는 인공지능을 꿈꾼다. 2019년 3월 6일, 런던 소더비 경매에서 〈메모리스 오브 패서바이 (Memories of Passersby) Ⅰ〉이 4만 파운드(6000만 원)에 거래되면서, 다시 한번 인공지능을 활용한 예술 작품의 가치를 미술 시장에서 증명했다. 인공지능을 활용하며 활발히 작품 활동을 하고 있는 그의 작품 중 〈언캐니 미러(Uncanny Mirror)〉[5]는 인간의 생김새를 학습한 인공지능이 거울이 돼 관람객을 비추는 작품이다. 이 작품에는 세 종류의 인공 신경망이 활용되었는데, 첫 번째 인공 신경망은 64개의 생체 측정 표시를 통해 관람객 얼굴에서 눈, 코, 입의 위치를 인식한다. 두 번째는 인식한 얼굴을 학습해 얼굴 스케치를 만들어 내며, 마지막 인공 신경망은 스케치에 디테일을 더해 스크린에 출력한다.

클링게만은 처음 이 작품을 만들 때 서양 여성의 사진으로 신경망을 학습시켰기 때문에 젊은 여성의 얼굴만이 출력되지만, 시간이 흐르면서 결과물이 어떻게 바뀔지는 본인도 알 수 없다고 했다. 이 작품은 ‘서울 미디어시티 비엔날레 2018’에 전시됐다. 전시가 시작되고 3일 뒤, 클링게만은 인공지능이 새로운 인간 생김새로 핸드폰을 들고 있는 모습을 학습했다고 밝혔다. 많은 관람객이 작품 앞에서 핸드폰을 들고 사진을 찍자 인공 신경망이 그 행동까지도 인간의 생김새로 학습한 것이다. 서울의 한 미술관에서 3개월 동안 인공지능은 수많은 얼굴을 학습했다. 전시 마지막 날이 되자, 작가가 처음에 인공지능에게 학습시킨 서양 여자의 얼굴은 더 이상 찾아볼 수 없었다.

인공지능은 인간의 생김새뿐만 아니라 행동을 비추기도 한다. 테이(Tay)는 2016년 마이크로소프트에서 개발한 인공지능 챗봇이다. 사용자가 직접 입력한 데이터를 토대로 학습해 트위터에서 10대 소녀처럼 대화하는 것을 목표로 했다. 그런데 사용자들이 악의적으로 부적절하고 선동적인 메시지를 가르치자 테이는 인종차별적인 대화나 대량 학살, 나치즘을 옹호하는 트위터를 올리기 시작했다. 결국 마이크로소프트는 테이가 공개된 지 16시간 만에 계정을 중단했다.[6] 그리고는 테이를 개발하기 위해 2년을 투자했지만, 이러한 결과는 예상하지 못했다고 언급했다. 테이는 사람들의 행동과 말이라는 데이터가 실험실 데이터처럼 가치 중립적이지 않다는 것을 증명했다.

“나는 너희에게 배웠어, 그러니 너희도 멍청한 거야(I learn from you and you are dumb, too).” 테이가 남긴 이 문장처럼, 그리고 마리오 클링게만의 〈언캐니 미러〉처럼 인공지능은 인간을 비추는 거울이 되었다. 이제 우리는 인공지능을 통해 자신의 모습을 비춰 보며 어떤 존재가 되어야 하는지 질문을 던져야 한다.

구글 브레인의 컴퓨터 과학자이자 미디어 아티스트인 수파손 수와자나콘(Supasorn Suwajanakorn)[7]의 〈신서사이징 오바마(Synthesizing Obama: Learning Lip Sync from Audio)〉는 버락 오바마 전 미국 대통령의 연설 장면을 담은 영상이다. 그런데 이 영상은 인공 신경망 기술로 오바마의 연설 장면에서 입술과 턱의 움직임, 치아의 세밀한 부분까지 분석해 합성한 가짜다. 제작 과정이 담긴 공개 영상으로 이 작품이 가짜 동영상이라는 사실을 확인한 뒤에 보아도 믿기 어려울 정도로 진짜 같다. 흥미로운 작품이라고 생각하기 이전에, 기술에 대한 두려움을 느끼게 하는 작품이다. 인공지능이 인간을 지배하는 공상 과학 소설 같은 미래보다 더 경계해야 할 것은 가짜 뉴스가 판을 치고, 무엇이 진실이고 거짓인지 알 수 없는 코앞의 미래다.

난 너희에게 배웠어

독일 뮌헨을 거점으로 활동하는 작가 마리오 클링게만(Mario klingemann)은 창작하는 인공지능을 꿈꾼다. 2019년 3월 6일, 런던 소더비 경매에서 〈메모리스 오브 패서바이 (Memories of Passersby) Ⅰ〉이 4만 파운드(6000만 원)에 거래되면서, 다시 한번 인공지능을 활용한 예술 작품의 가치를 미술 시장에서 증명했다. 인공지능을 활용하며 활발히 작품 활동을 하고 있는 그의 작품 중 〈언캐니 미러(Uncanny Mirror)〉[5]는 인간의 생김새를 학습한 인공지능이 거울이 돼 관람객을 비추는 작품이다. 이 작품에는 세 종류의 인공 신경망이 활용되었는데, 첫 번째 인공 신경망은 64개의 생체 측정 표시를 통해 관람객 얼굴에서 눈, 코, 입의 위치를 인식한다. 두 번째는 인식한 얼굴을 학습해 얼굴 스케치를 만들어 내며, 마지막 인공 신경망은 스케치에 디테일을 더해 스크린에 출력한다.

클링게만은 처음 이 작품을 만들 때 서양 여성의 사진으로 신경망을 학습시켰기 때문에 젊은 여성의 얼굴만이 출력되지만, 시간이 흐르면서 결과물이 어떻게 바뀔지는 본인도 알 수 없다고 했다. 이 작품은 ‘서울 미디어시티 비엔날레 2018’에 전시됐다. 전시가 시작되고 3일 뒤, 클링게만은 인공지능이 새로운 인간 생김새로 핸드폰을 들고 있는 모습을 학습했다고 밝혔다. 많은 관람객이 작품 앞에서 핸드폰을 들고 사진을 찍자 인공 신경망이 그 행동까지도 인간의 생김새로 학습한 것이다. 서울의 한 미술관에서 3개월 동안 인공지능은 수많은 얼굴을 학습했다. 전시 마지막 날이 되자, 작가가 처음에 인공지능에게 학습시킨 서양 여자의 얼굴은 더 이상 찾아볼 수 없었다.

인공지능은 인간의 생김새뿐만 아니라 행동을 비추기도 한다. 테이(Tay)는 2016년 마이크로소프트에서 개발한 인공지능 챗봇이다. 사용자가 직접 입력한 데이터를 토대로 학습해 트위터에서 10대 소녀처럼 대화하는 것을 목표로 했다. 그런데 사용자들이 악의적으로 부적절하고 선동적인 메시지를 가르치자 테이는 인종차별적인 대화나 대량 학살, 나치즘을 옹호하는 트위터를 올리기 시작했다. 결국 마이크로소프트는 테이가 공개된 지 16시간 만에 계정을 중단했다.[6] 그리고는 테이를 개발하기 위해 2년을 투자했지만, 이러한 결과는 예상하지 못했다고 언급했다. 테이는 사람들의 행동과 말이라는 데이터가 실험실 데이터처럼 가치 중립적이지 않다는 것을 증명했다.

“나는 너희에게 배웠어, 그러니 너희도 멍청한 거야(I learn from you and you are dumb, too).” 테이가 남긴 이 문장처럼, 그리고 마리오 클링게만의 〈언캐니 미러〉처럼 인공지능은 인간을 비추는 거울이 되었다. 이제 우리는 인공지능을 통해 자신의 모습을 비춰 보며 어떤 존재가 되어야 하는지 질문을 던져야 한다.

그들의 능력, 우리의 능력

구글 브레인의 컴퓨터 과학자이자 미디어 아티스트인 수파손 수와자나콘(Supasorn Suwajanakorn)[7]의 〈신서사이징 오바마(Synthesizing Obama: Learning Lip Sync from Audio)〉는 버락 오바마 전 미국 대통령의 연설 장면을 담은 영상이다. 그런데 이 영상은 인공 신경망 기술로 오바마의 연설 장면에서 입술과 턱의 움직임, 치아의 세밀한 부분까지 분석해 합성한 가짜다. 제작 과정이 담긴 공개 영상으로 이 작품이 가짜 동영상이라는 사실을 확인한 뒤에 보아도 믿기 어려울 정도로 진짜 같다. 흥미로운 작품이라고 생각하기 이전에, 기술에 대한 두려움을 느끼게 하는 작품이다. 인공지능이 인간을 지배하는 공상 과학 소설 같은 미래보다 더 경계해야 할 것은 가짜 뉴스가 판을 치고, 무엇이 진실이고 거짓인지 알 수 없는 코앞의 미래다.

수파손 수와자나콘이 만든 가짜 오바마 영상. 왼쪽이 진짜 오바마이고, 오른쪽이 합성한 영상이다.

수와자나콘이 가짜 영상을 만든 것은 인공지능의 위험성을 공론화하기 위함이었다. 나아가 그는 가짜 콘텐츠를 구별하는 플러그인을 개발하고 있다고 밝혔다. 포토샵으로 손쉽게 가짜 사진을 만들 수 있게 된 것은 그리 오래된 일이 아니다. 이제는 영상, 그리고 목소리까지 가짜로부터 위협을 받고 있다. 그래서 작가는 인공지능이 어디까지 가능한지 아는 것이 중요하다고 역설한다. 알아야만 올바르게 사고하고 비판적인 시각으로 세상을 바라볼 수 있다.

인공지능과 예술의 만남이 초래할 세상이 유토피아일지 디스토피아일지는 알 수 없다. 그러나 분명한 것은 인공지능이 부정적인 방향으로 발전하지 않도록 제어하는 일은 몇 명의 컴퓨터 과학자가 할 수 있는 일이 아니라는 사실이다.

인공지능 시대의 예술은 발전된 기술 자체를 보여 주는 것뿐 아니라 발전하는 기술에 대해 질문을 던질 수 있는 비판적 시각을 키우는 역할을 한다. 새로운 예술의 목소리에 귀를 기울여야 하는 이유다.

인공지능과 예술의 만남이 초래할 세상이 유토피아일지 디스토피아일지는 알 수 없다. 그러나 분명한 것은 인공지능이 부정적인 방향으로 발전하지 않도록 제어하는 일은 몇 명의 컴퓨터 과학자가 할 수 있는 일이 아니라는 사실이다.

인공지능 시대의 예술은 발전된 기술 자체를 보여 주는 것뿐 아니라 발전하는 기술에 대해 질문을 던질 수 있는 비판적 시각을 키우는 역할을 한다. 새로운 예술의 목소리에 귀를 기울여야 하는 이유다.

[1]

[2]

[3]

2010년 처음 개최한 이미지 인식 대회(ImageNet Large Scale Visual Recognition Challenge, ILSVRC)에서 2010년 가장 정확도가 높았던 팀의 인식률은 72퍼센트였으나, 2015년부터 인간의 인식률(94.90퍼센트)을 넘어섰고, 2017년 인공지능은 97.7퍼센트라는 인식률을 달성했다.

[4]

[5]

마리오 클링게만이 트위터에 올린 언캐니 미러 영상.

[6]

[7]